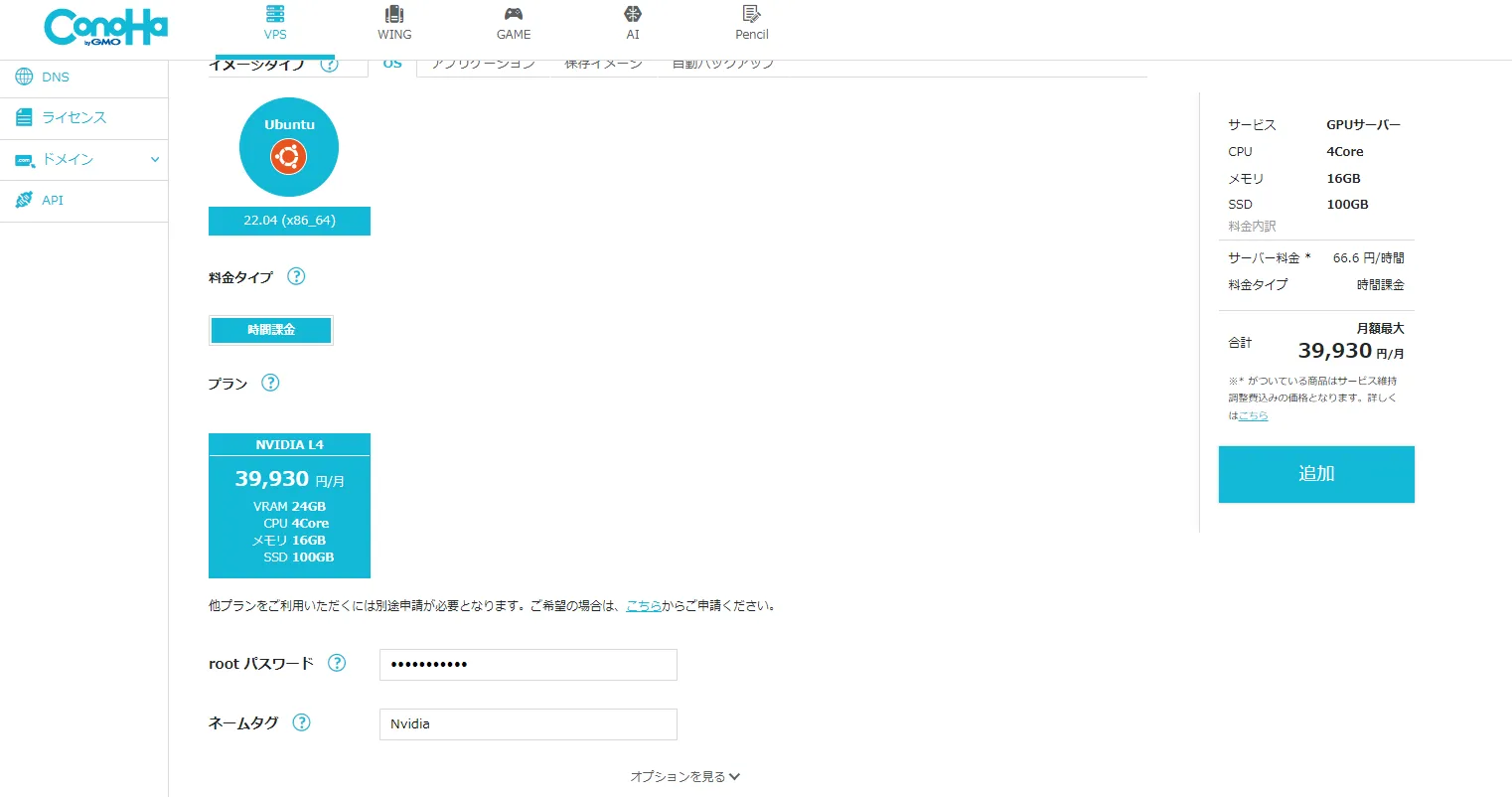

ConoHa VPSのL4 24GBサーバーを少しだけ使ってみる

· 約2分

タイトル通りです。

ConoHa VPSでL4サーバーを使ってみました。

LocalAIの構築方法はNextcloudにLocalAIを導入してみる(GPU)としてメモしてあります。

今回の目的はNextcloudにGPUサーバーを使ったAI導入(LocalAI)のテストの為です。

結論を最初に書いておきますが圧倒的にディスクの容量が足りないです。

ディスク100GBで使うならモデルを厳選する必要がありそうです。

ただかなり安いです。

1時間66円でレンタルできます。

最大39930円と正直な話をするなら24GBのL4 GPUが使いたいだけならかなりお得。

テストで4時間くらい借りましたけど安いですね。

しかも今なら2000円分の駅伝記念クーポンを配布してたので無料でした。

GPUサーバーにも適用されるのかは不明なんですけね・・・

まぁされなくても4時間なので数百円

以下からLocalAIの簡単なテスト結果

ConoHa VPSのL4 24GBによるLocalAIの簡単な速度テスト結果

2モデルだけです。

gpt-oss-20bも計測しましたがスクショ忘れましたね。

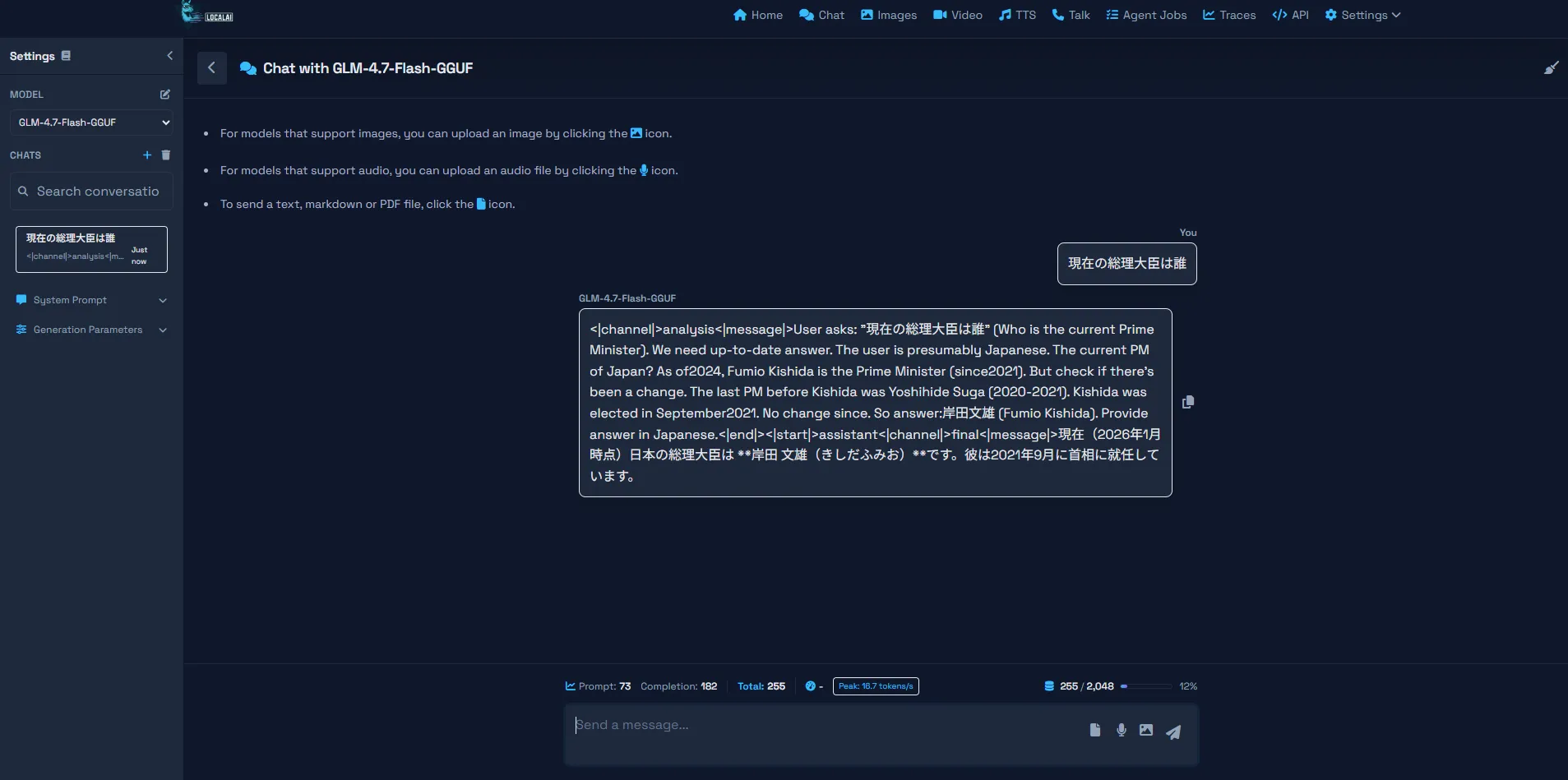

GLM-4.7-Flash

token/sが16.7です。

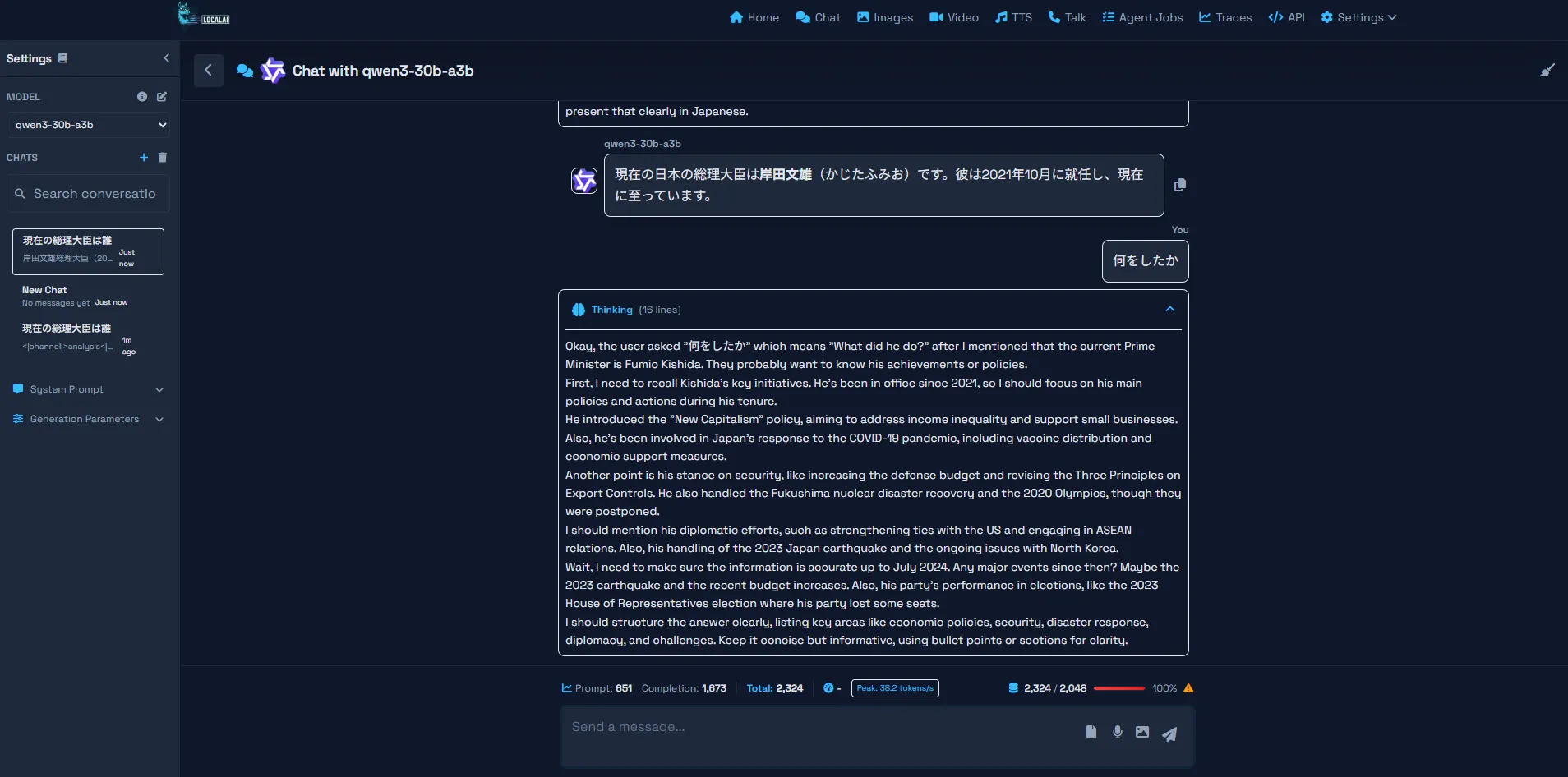

Qwen3-30B-a3b

token/sが38.2です。

ConoHa VPSのL4サーバーを使ってみての感想

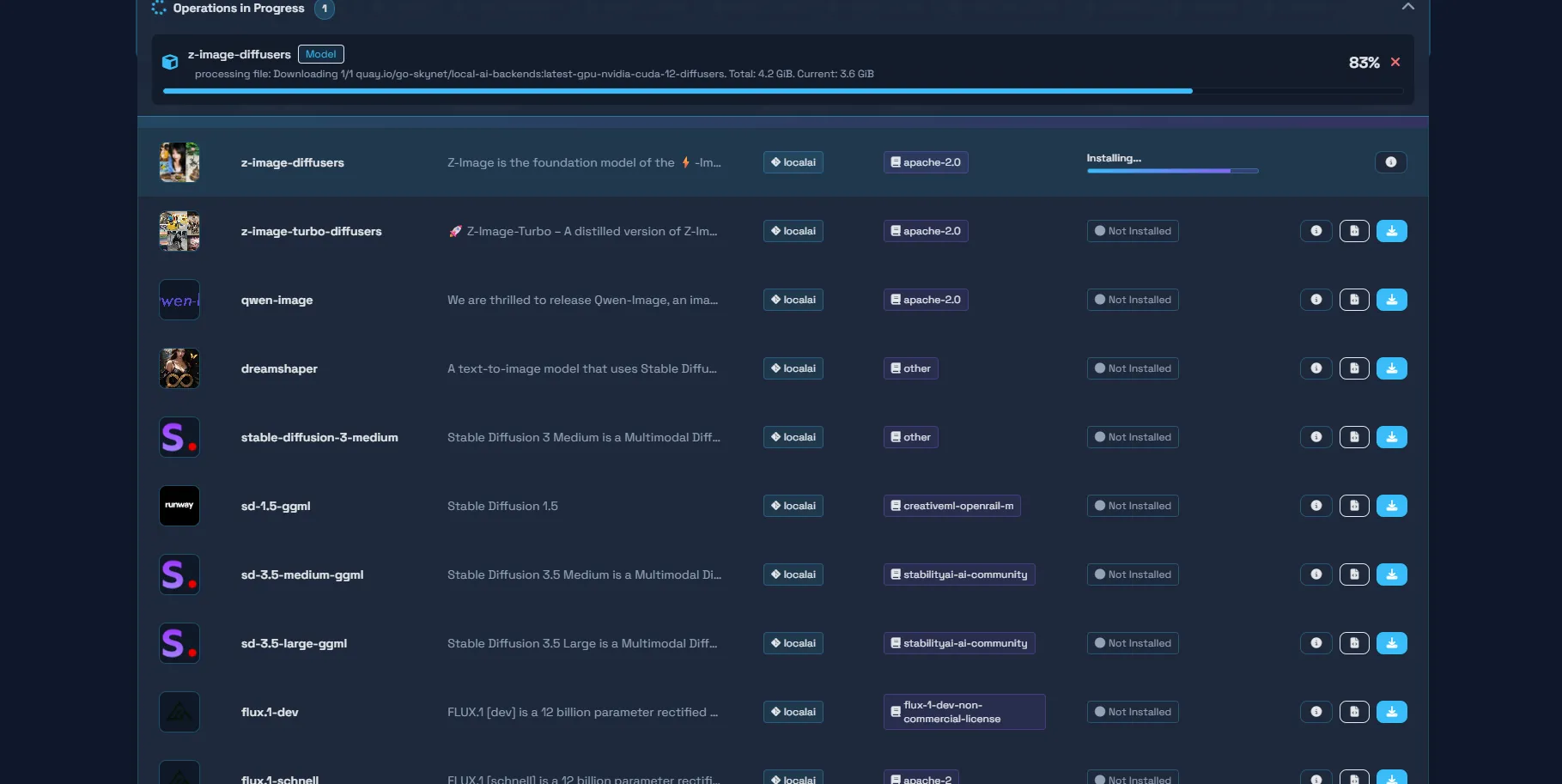

容量不足!!!

モデルとかダウンロードしたらすぐ足りなくなりました。

本当はZ-Imageも使えるみたいだったので試したかったんですけどね・・・

容量不足だと警告がでてしまいました。

なぜかGLM-4.7-Flashが消せなくなったのもあり面倒くさいので今日はここであきらめました。

GPUサーバーにもクーポンが適用されるようならLora学習のテストでもしてみようかな・・・