Windowsのllm-scaler-omniでComfyUIをテストしてみる

WSL 2でllm-scalerが動かなかったのでomniも放置してましたけどWindows用ファイルがあるみたいだったのでテストです。

結果書いときますがWindows版は少し古いのが自動で入るので初期だとZ-imageとかも動かない感じでした(残念)

詳細はhttps://github.com/intel/llm-scaler/tree/main/omni/comfyui_windows_setup

起動方法

コードを取得

git clone https://github.com/intel/llm-scaler.git

cd llm-scaler\omni\

Condaで環境構築

Anacondaのインストールが必要です

Anaconda Promptから私は実行

ダウンロード

.\init_conda_env.bat

起動

cd ComfyUI

conda activate omni_env

python .\main.py --listen 0.0.0.0

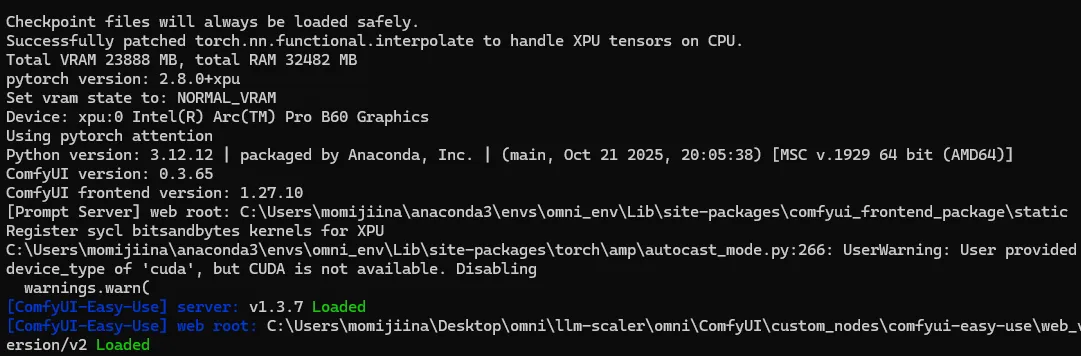

一応、起動できました

とりあえず問題はなさそうでした。

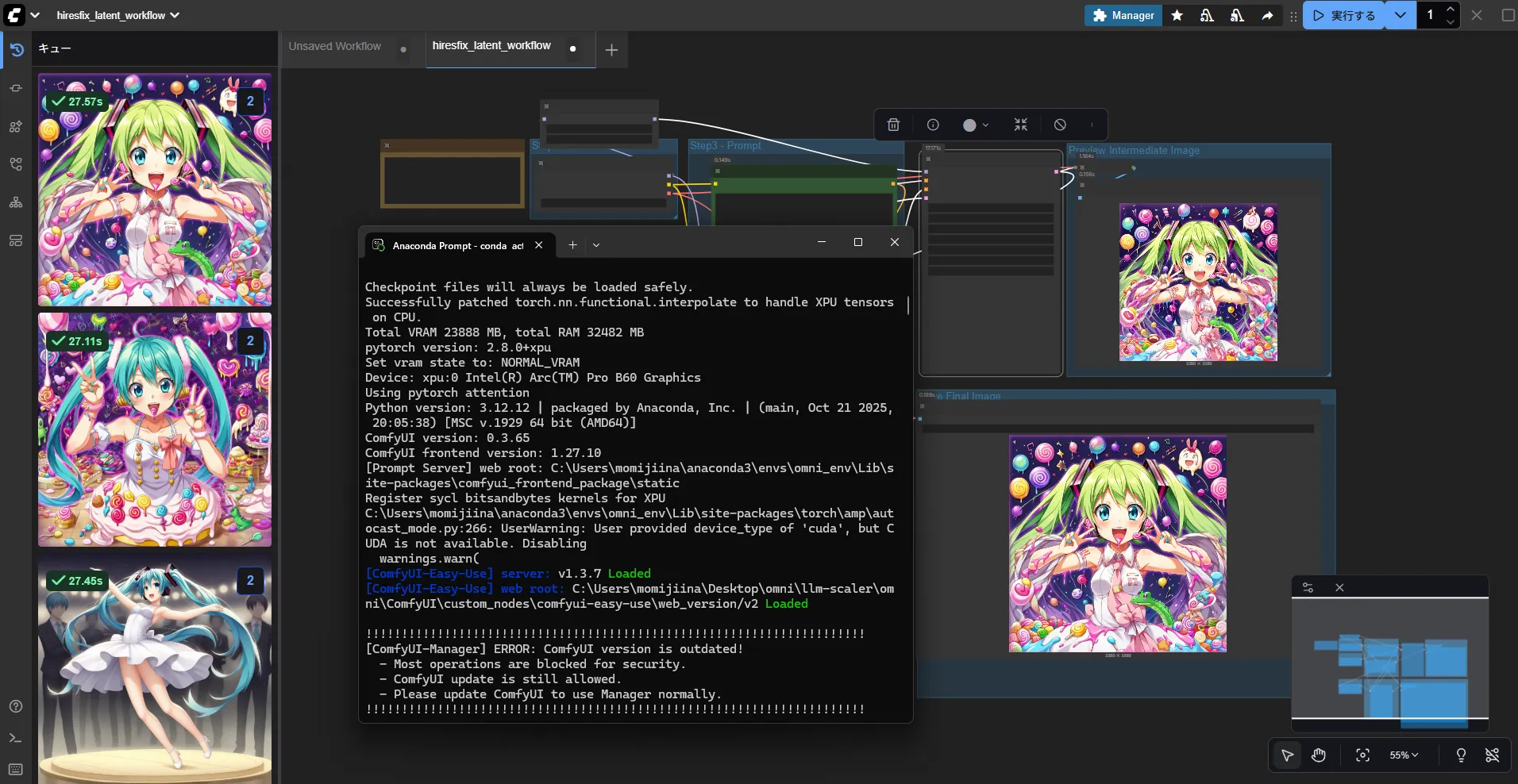

2枚認識してくれるとかの特別な機能もなく普通

Ponyで画像生してみた

とりあえず適当に生成してみましたが別に早くなった感じもなしです。

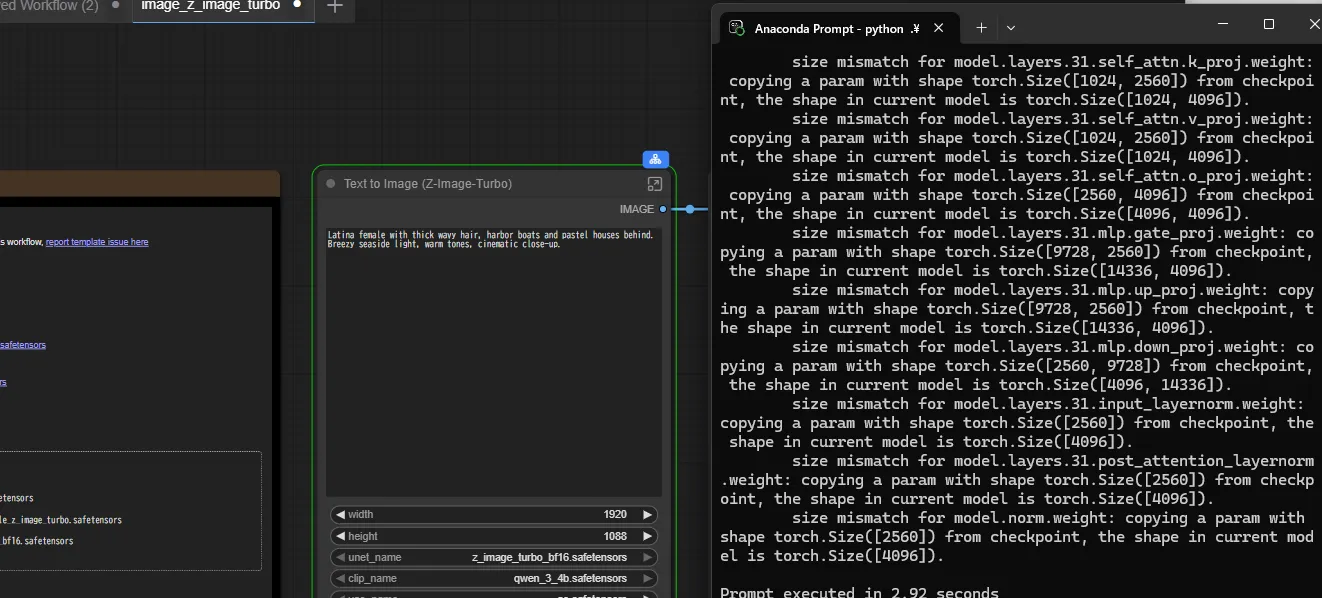

Z-Image-turboで画像生成してみる

エラーがでてできませんでしたね。

アップデート方法が不明(だった)

ComfyUIのアップデート方法が不明でした。

公式は以下でアップデートできるとのこと

cd ComfyUI

git stash

git fetch origin

git pull

git stash pop

ただこれを実行してもgitでエラーでますし無理やりマスターに合わせてアップデートしたらCudaがないと動かないとエラーを吐きました。

batの編集がいりそうなのと速度も速くなったとかもなさそうなのでAI PlaygroundのComfyUIを使うかUbuntuで実行したほうがいいかもですね。

※アップデートのとこだけ見てて忘れてましたがパッチが一応あったみたいです。

速度はあがったか?

AI PlaygroundのComfyと比べても速度があがった感じはないですね。

Ubuntuでちゃんとしたやつ動かせば差がでるのかは検証が必要です。

最後に

LM Studioとかの最適化がいつされるのかわからないのもあるのでUbuntuでArc Pro B60 48GBだと速度に差がでるのか試してみます。

llm-scalerで速度が改善するならWindowsから変更ですね。

vllmが最適かされてるらしいので2倍とかでるかも?(不明)