WSLでllm-scalerのvllmもテストする

· 約4分

一応,Ubuntu24でテストしてみていける気がしたのでテストしてみましたが

LM Studioより速度が速くなるとかはなかったです。

一人で使うならLM Studioでよさそうです。

一応ですがWSLでの実行はあまりお勧めしないです。

パラメーターを細かく指定しないとすぐエラーです。

WSLにvllmを入れる

今回はUbuntu 24しかなかったので24ですね。

ドライバーインストール

公式を一応みてください

dgpu-docs-intel

sudo apt-get update

sudo apt-get install -y software-properties-common

sudo add-apt-repository -y ppa:kobuk-team/intel-graphics

sudo apt-get install -y libze-intel-gpu1 libze1 intel-metrics-discovery intel-opencl-icd clinfo intel-gsc

sudo apt-get install -y intel-media-va-driver-non-free libmfx-gen1 libvpl2 libvpl-tools libva-glx2 va-driver-all vainfo

sudo apt-get install -y libze-dev intel-ocloc

sudo apt-get install -y libze-intel-gpu-raytracing

base-toolkitをインストール

公式を見てください

base-toolkit

Ubuntu25ではわかりませんが24では少し更新しないとパッケージは見つかりません。

公開鍵の取得

wget -O- https://apt.repos.intel.com/intel-gpg-keys/GPG-PUB-KEY-INTEL-SW-PRODUCTS.PUB \

| gpg --dearmor | sudo tee /usr/share/keyrings/oneapi-archive-keyring.gpg > /dev/null

リポジトリの追加

echo "deb [signed-by=/usr/share/keyrings/oneapi-archive-keyring.gpg] https://apt.repos.intel.com/oneapi all main" \

| sudo tee /etc/apt/sources.list.d/oneAPI.list

インストール

終わったらrebootかけてください

sudo apt update

sudo apt install intel-oneapi-base-toolkit

vllmをdockerで起動する

使うバージョンは最新ですが必要があれば変更してください。

一覧

sudo docker run -it --name my-vllm \

--shm-size 16g \

--privileged \

--device /dev/dri:/dev/dri \

-v /usr/lib/wsl:/usr/lib/wsl \

-e LD_LIBRARY_PATH=/usr/lib/wsl/lib \

--entrypoint /bin/bash \

intel/vllm:latest

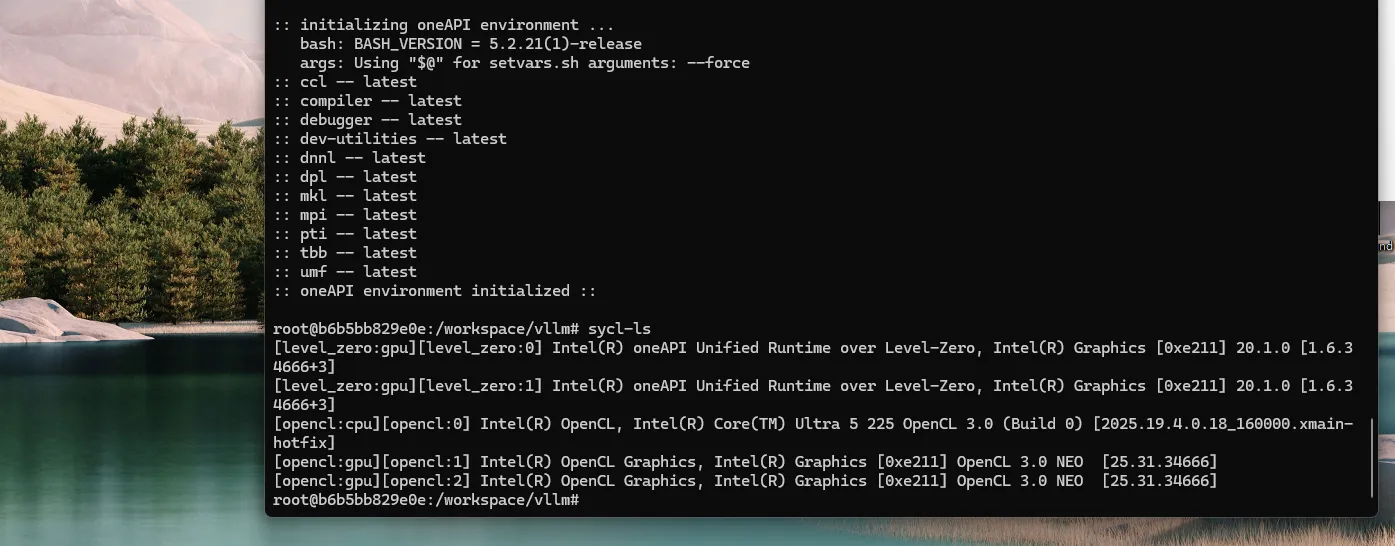

GPUの認識確認

勝手にコンテナに入るはずなので以下を実行する

sycl-ls

モデルダウンロード開始

export VLLM_WORKER_MULTIPROC_METHOD=spawn

export VLLM_LOGGING_LEVEL=INFO

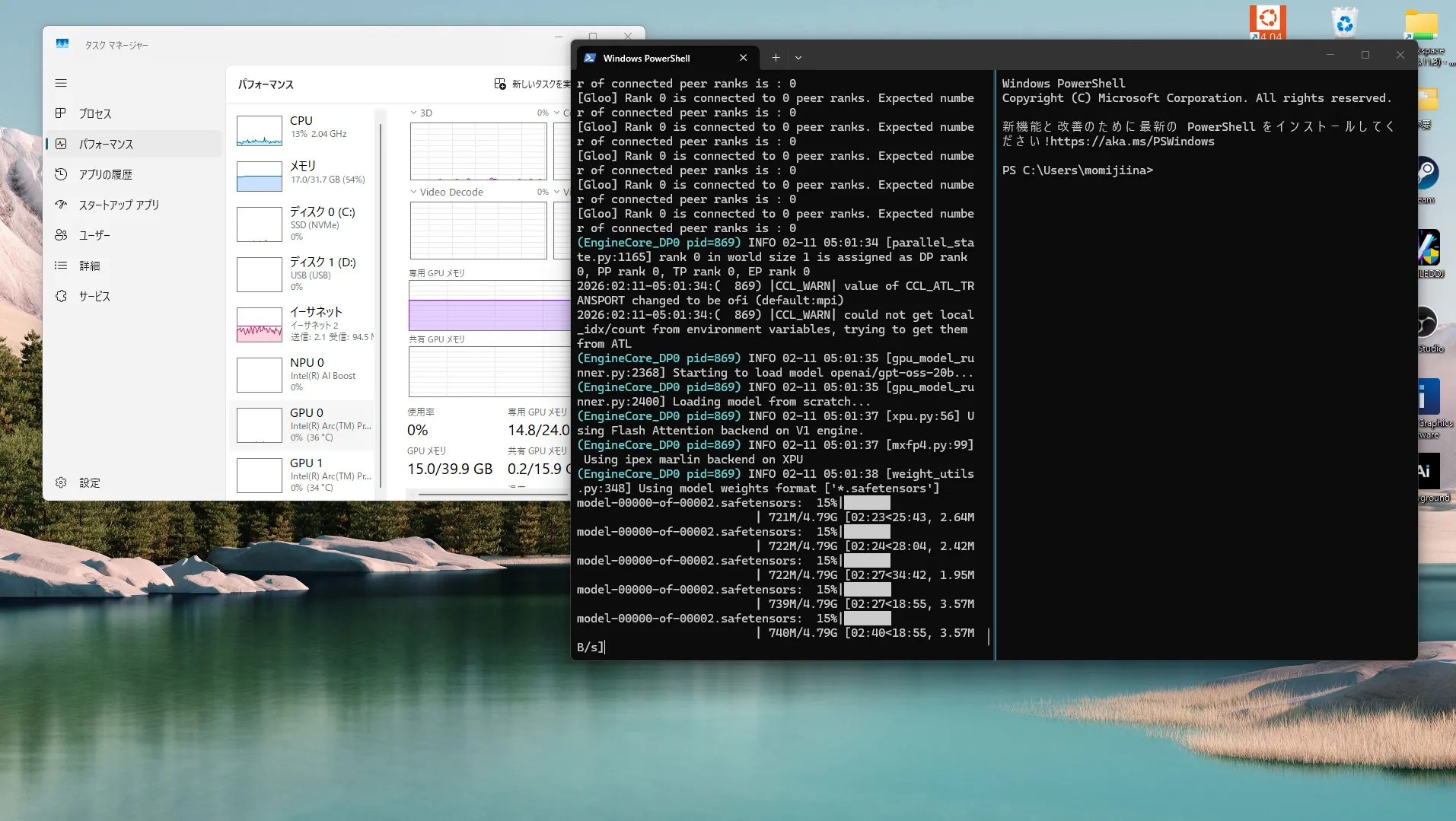

Qwen3 30bだとあふれたのでgpt-oss-20bを指定

サポートモデル一覧

20bでもwslだとすこしあふれたのであきらめ

VLLM_WORKER_MULTIPROC_METHOD=spawn vllm serve openai/gpt-oss-20b \

--dtype float16 \

--enforce-eager \

--port 8000 \

--host 0.0.0.0 \

--trust-remote-code \

--gpu-memory-util 0.9 \

# vllmなら下だけどこれもエラーはなかった

#--gpu-memory-utilization 0.9 \

--max-model-len 8192 \

--tensor-parallel-size 1

## どっちでも動く

##-tp 1

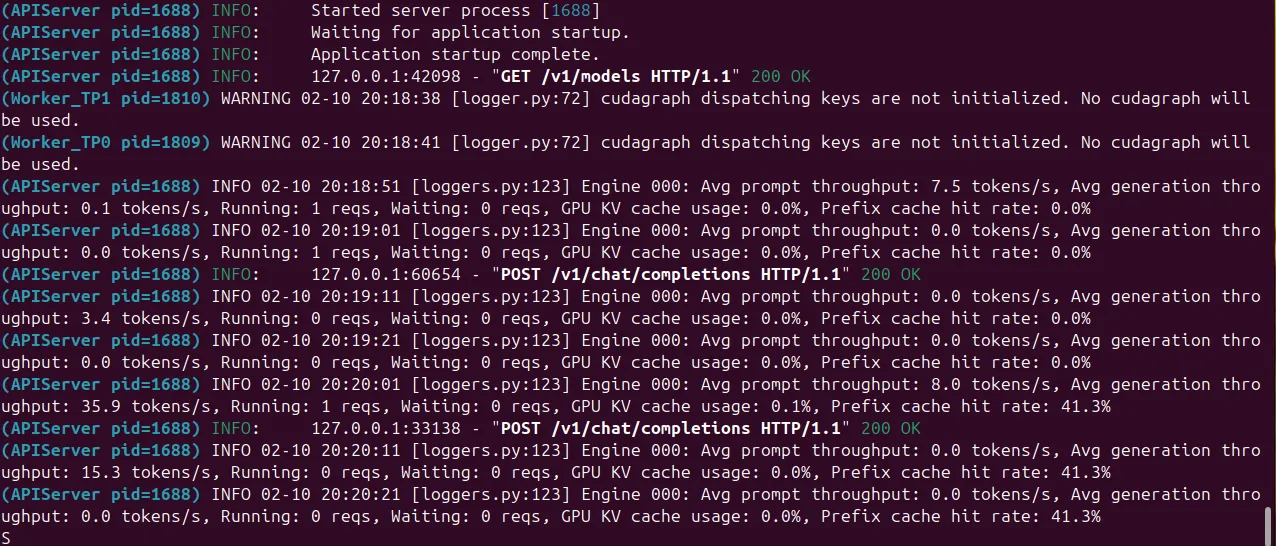

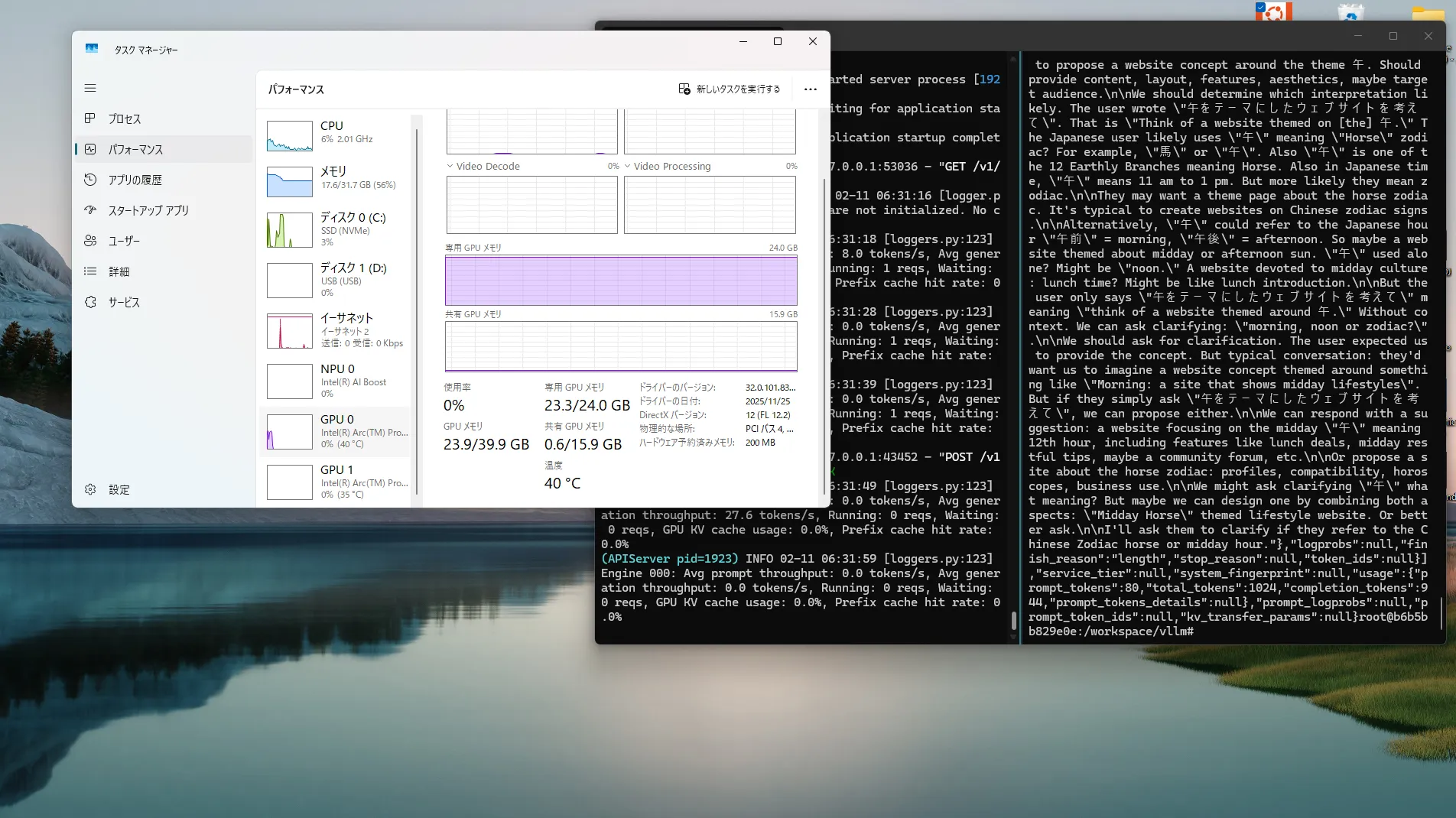

速度確認

プロンプトによって早かったり遅かったり

vllmは分散用?かもしれないですね。

WSLのせいなのかなんかちょっと共有にもれてますし・・・

他のとどっちがいいか

私はLM StudioかOllamaを使うことにしました。

速度もむしろLM Studioのほうが早そう。

2枚に分散するとクラッシュしたのでバージョンを下げるかしないのかダメそうだったので誰か検証してください・・・