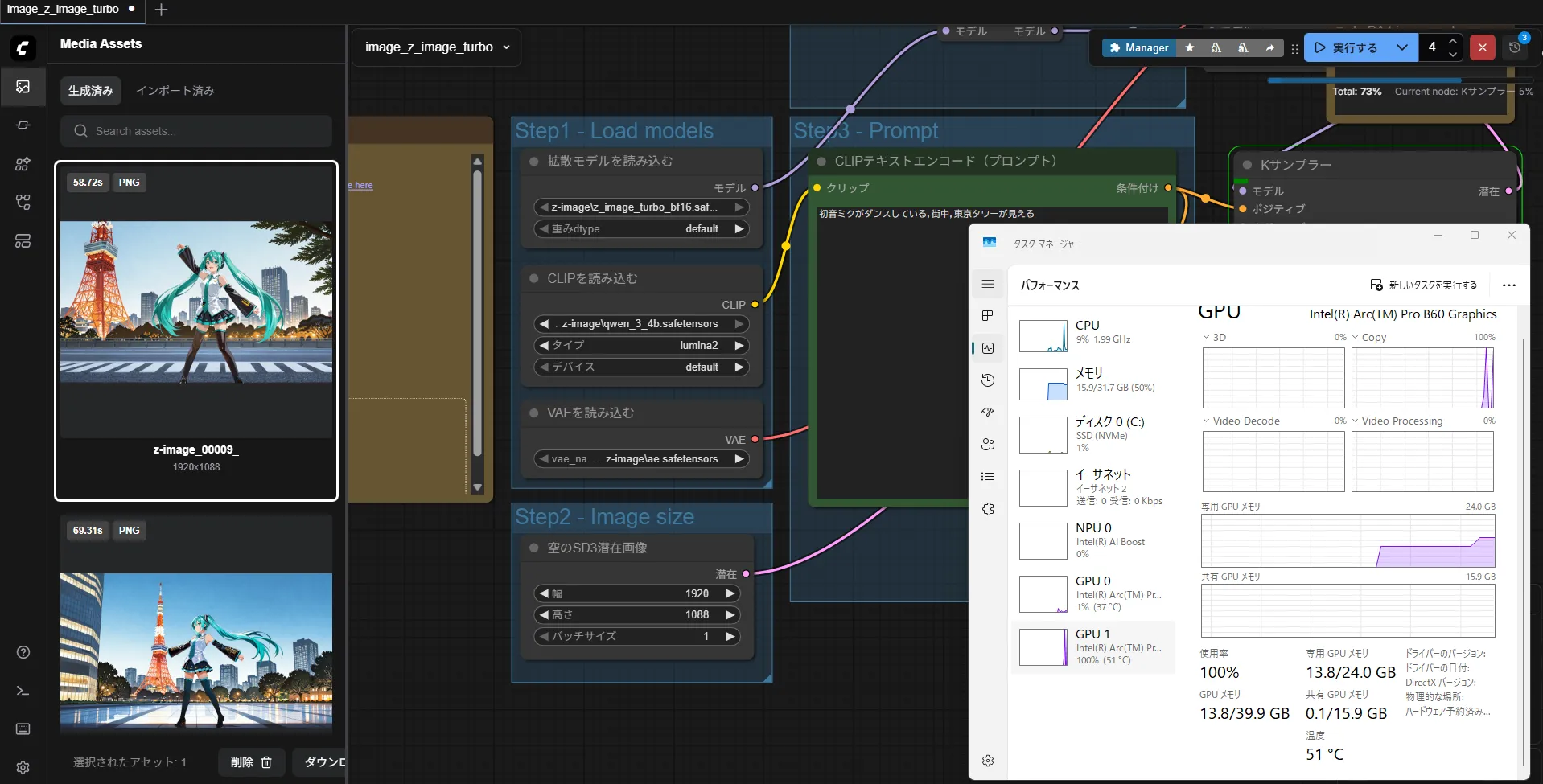

Qwen-Image-2512が出ましたね・・・・

Loraがそのまま使えると思ったのですがね・・・

ダメでしたので作り直しました。

前のやつの修正版なのもあり何かが変わったわけではないので簡単な比較です。

(人などがリアルになったり細かい描写の修正らしいですがLoraメインの私には人がリアルになってもあまり・・・)

あとは結局,Z-ImageもQwenもそうですがNSFWが微妙なんですよね。

それもあって結局、みんなStable Diffusionですよね。

そろそろ規制解除版でたのかな?

一応、結論を書いておきますがLora適用時の安定性が少し増していました。

もしかしたらai-toolkitのLora作成用データが良くなっただけの可能性もありますが後でヴィタちゃんLoraを作成して考えます。

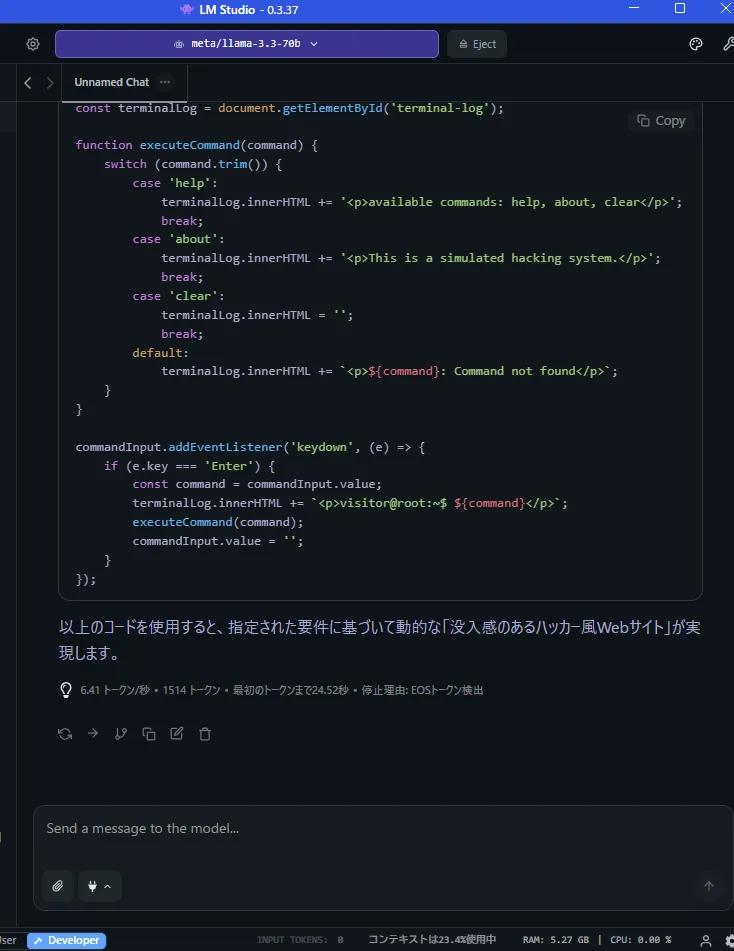

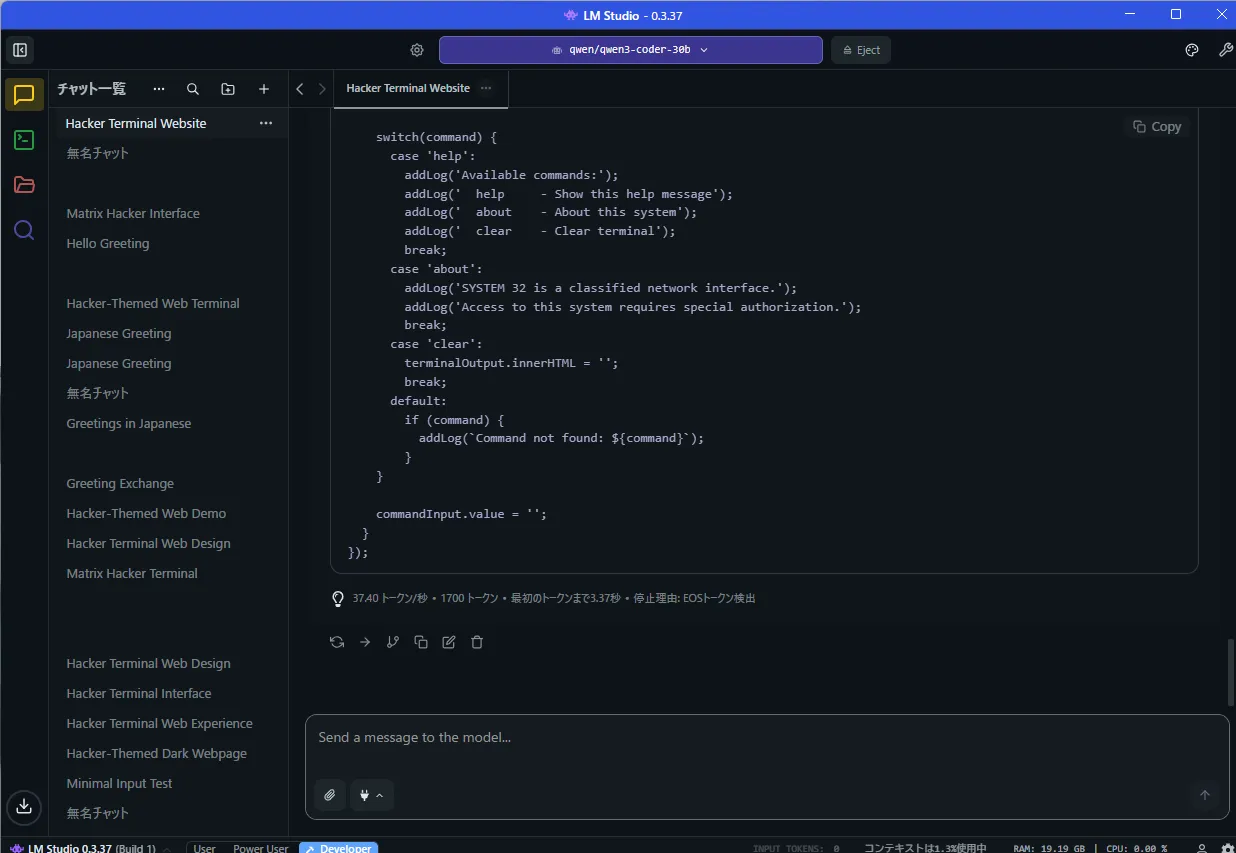

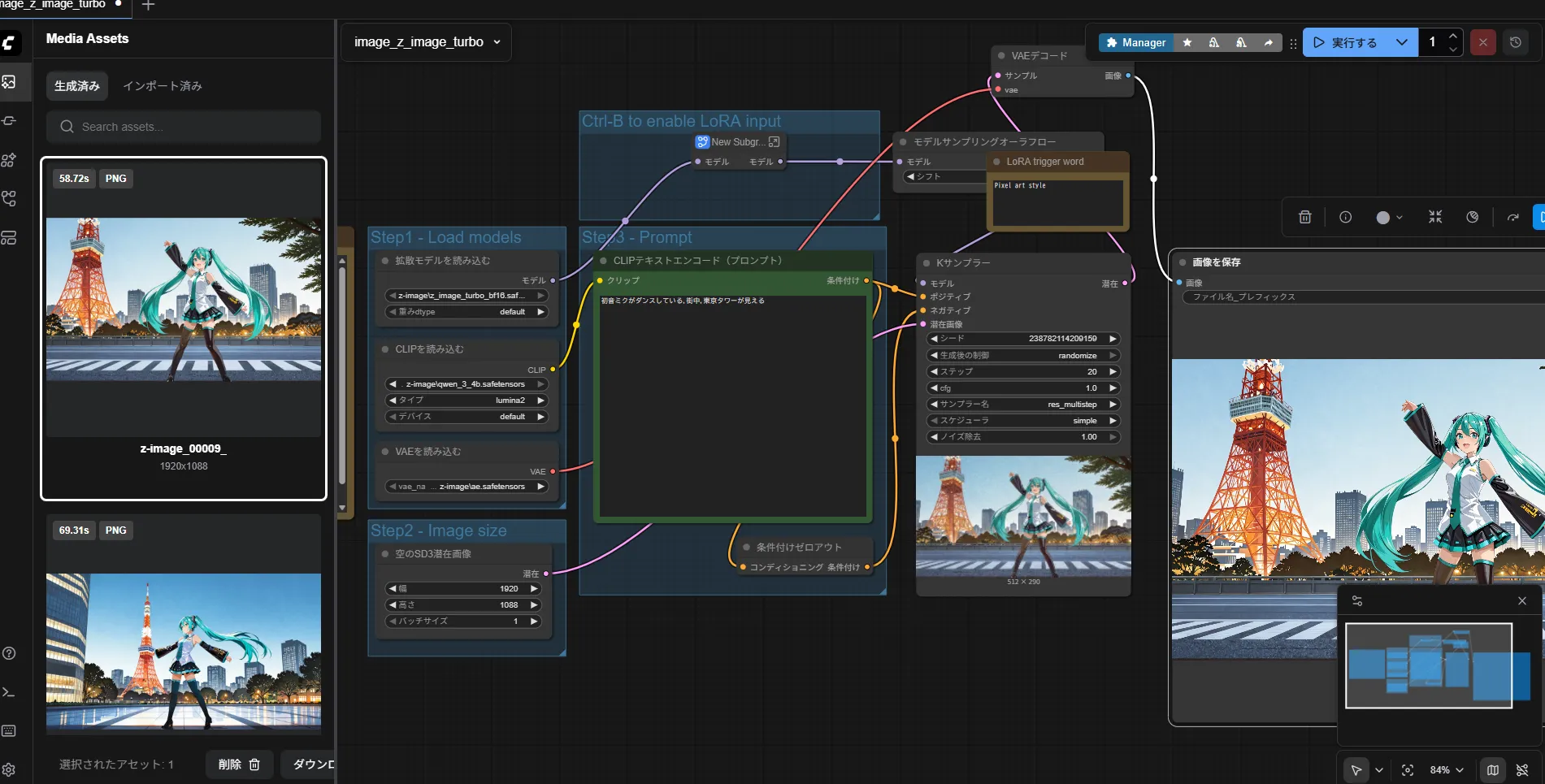

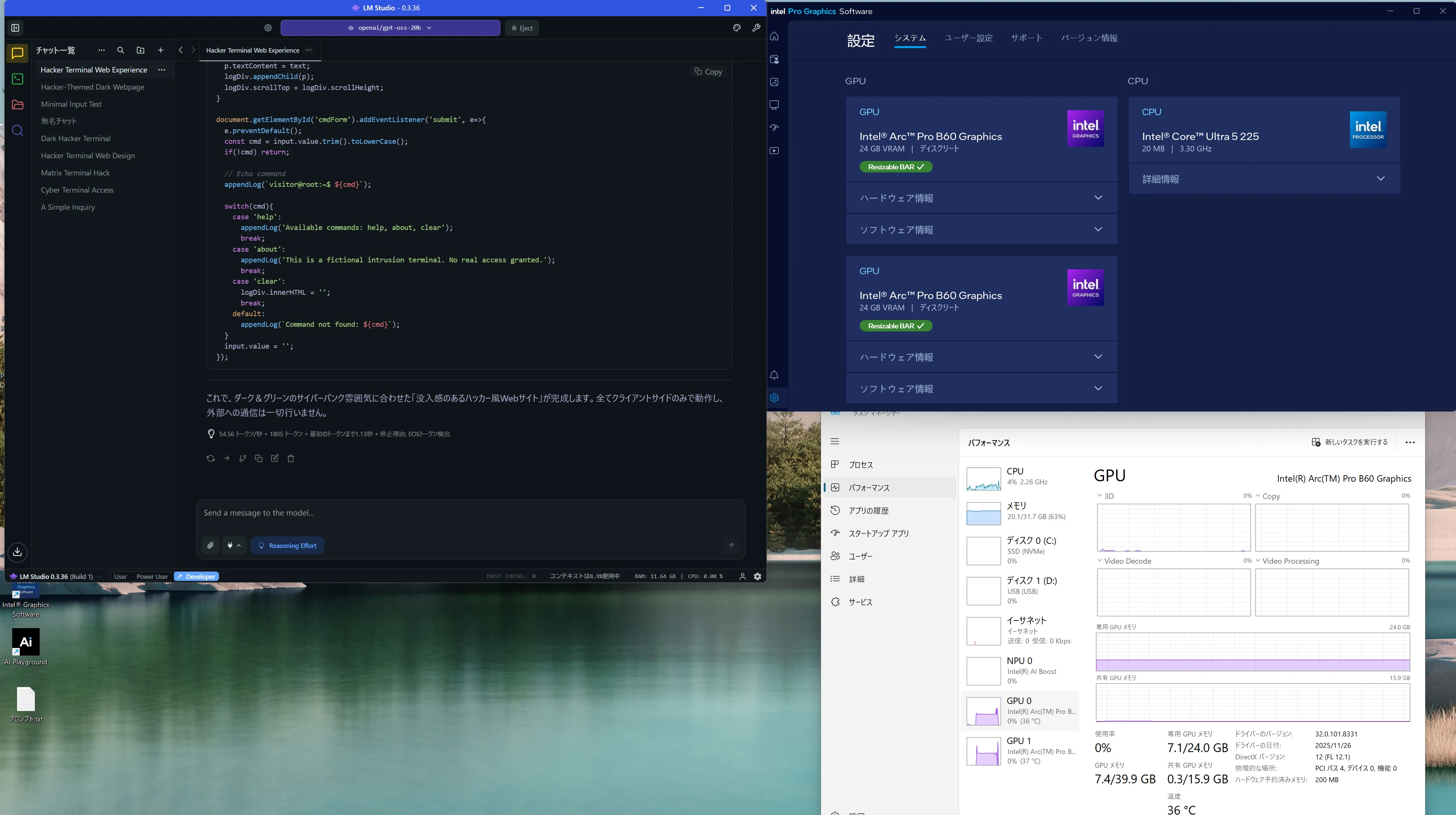

Qwen-Image-2512のLoraの作成方法

一応、書いておきます。

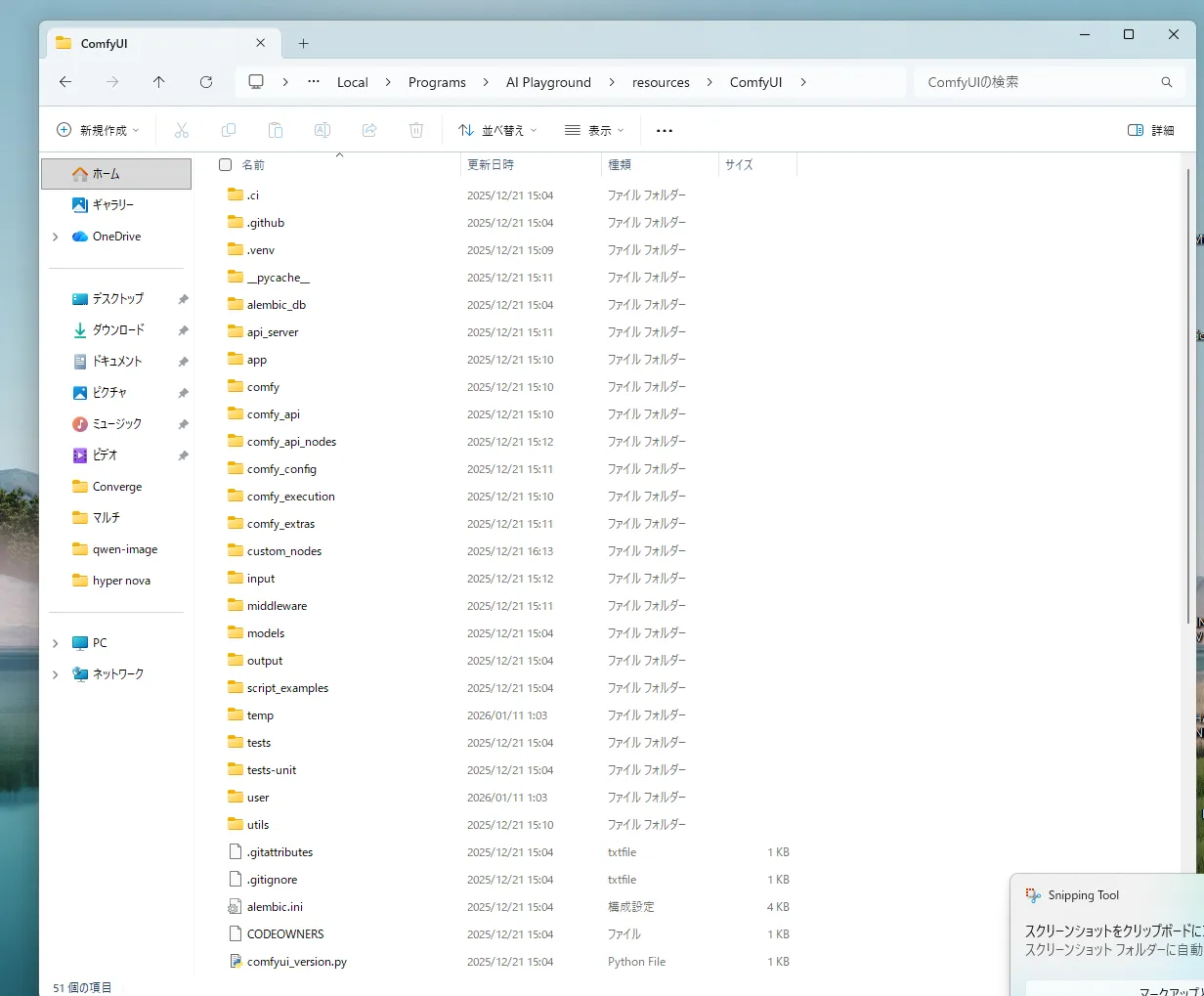

今回,Lora作成にはQwen-Image,Z-Imageと同じくai-toolkitを使用しています。

https://github.com/ostris/ai-toolkit

RTX50シリーズだと以下で動きます。

RTX5090で今回もQwen-Image-2512専用で再インストールしているので問題ないですがもしかしたらそろそろtorchが新しくでてるかもしれなです。

面倒くさいので確認してないので安定性を求める方は最新版がでてないか確認してみてください。

git clone https://github.com/ostris/ai-toolkit.git

cd ai-toolkit

python -m venv venv

.\venv\Scripts\activate

pip install --pre torch torchvision torchaudio --index-url https://download.pytorch.org/whl/nightly/cu128

pip install -r requirements.txt

起動

cd ui

npm run build_and_start

一回,buildした後は以下のほうが起動が早いです。

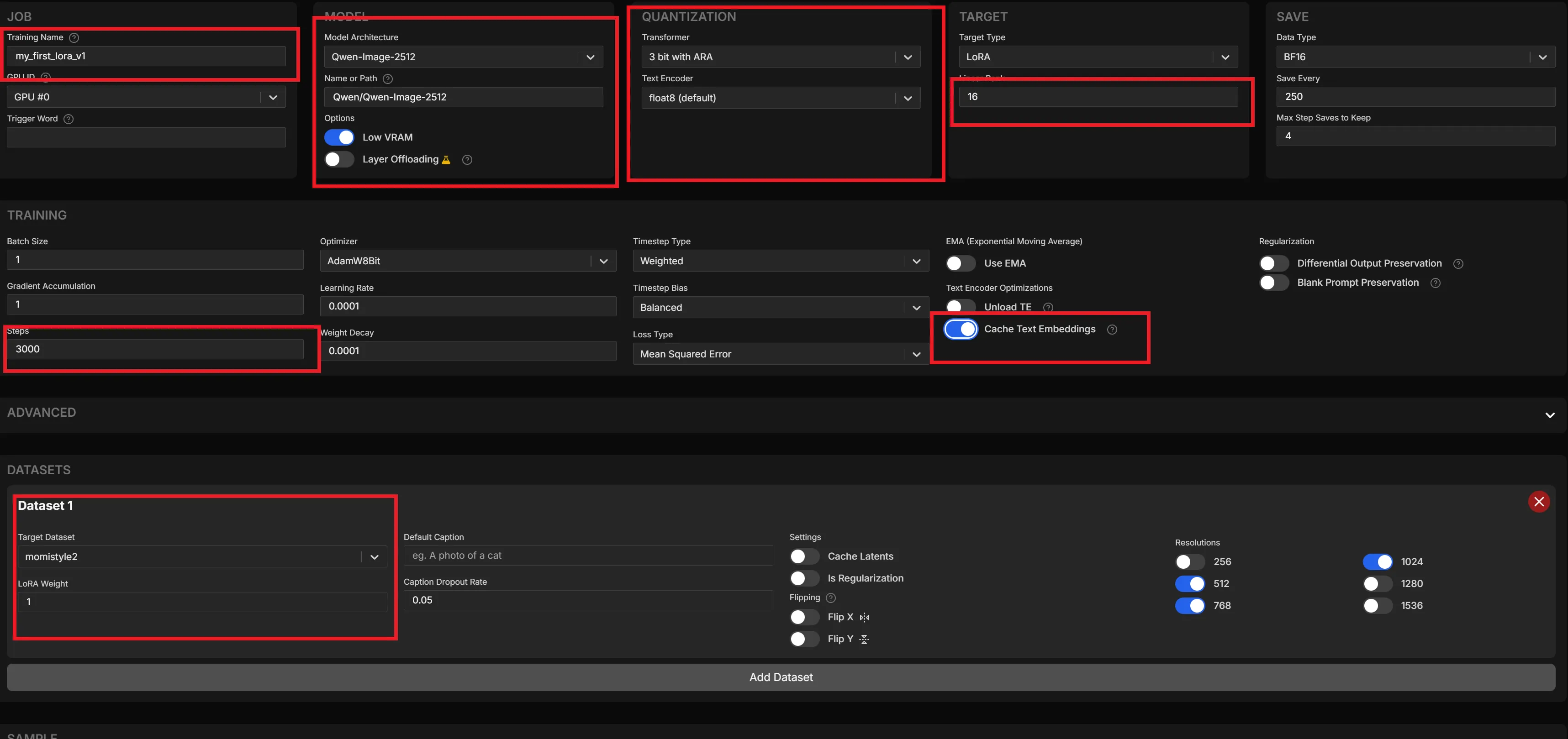

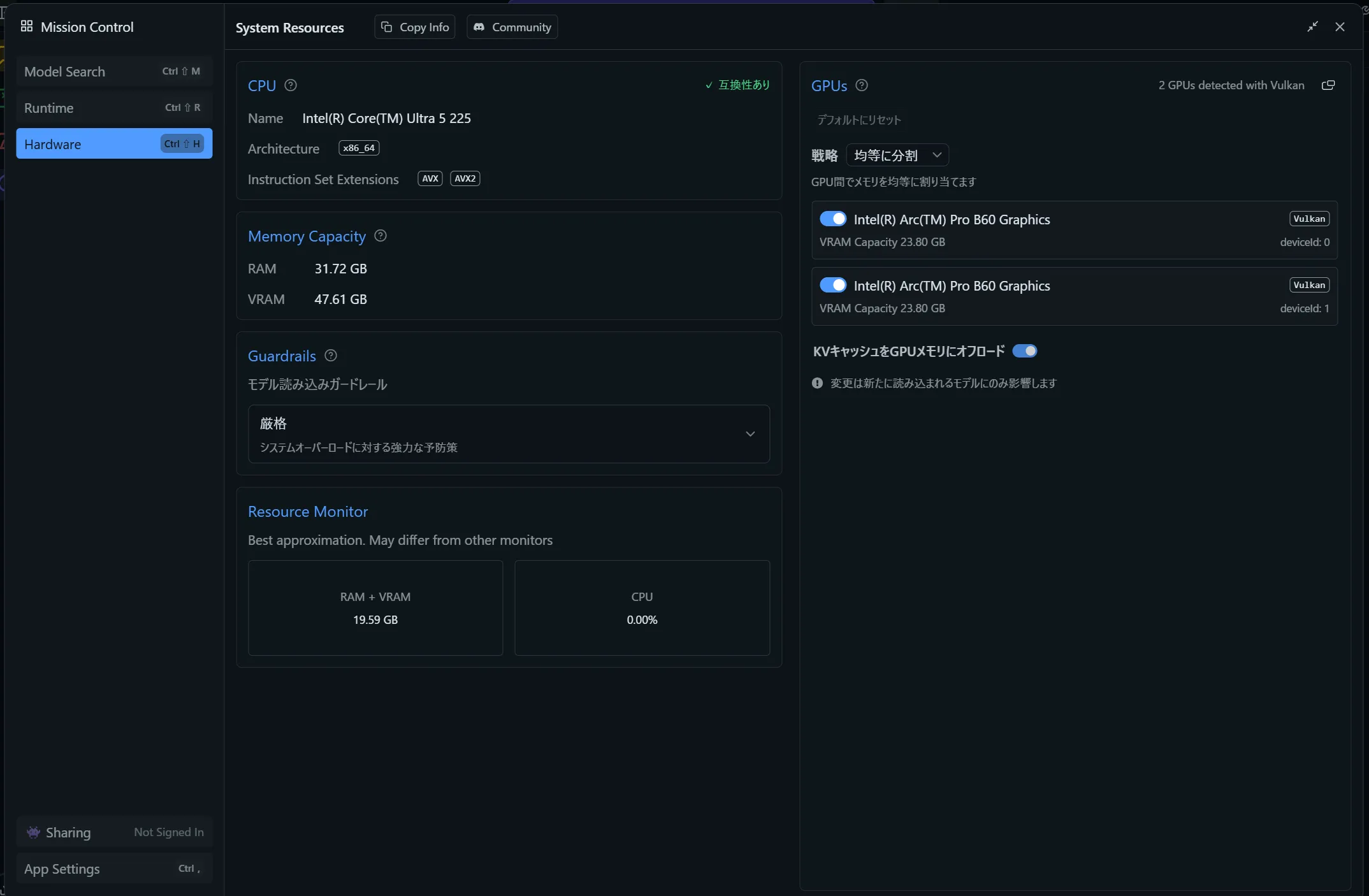

New Jobでだいたい以下の設定にしてもらえれば動きます(ai-toolkit公式からのおすすめです。)

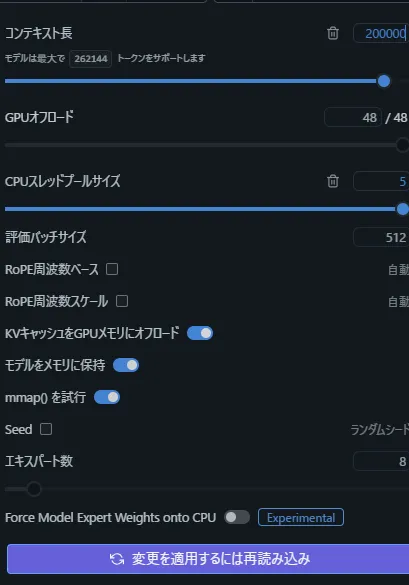

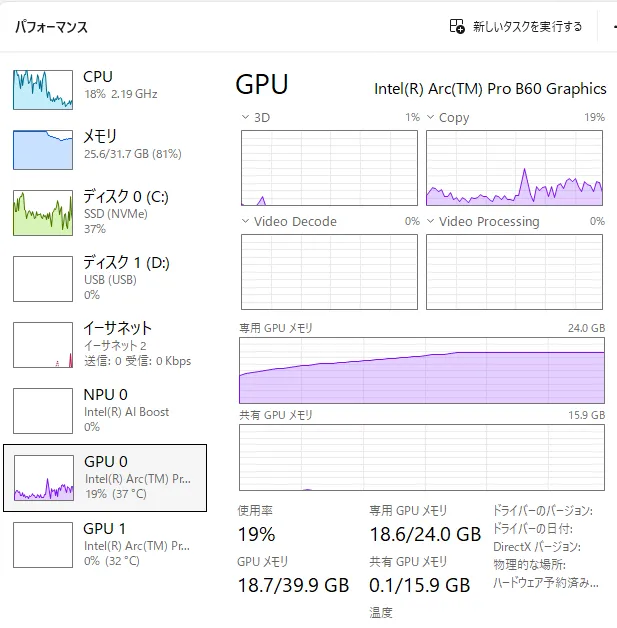

3bit with ARAが24GB推奨です。

4bit with ARA が32GB推奨です。

私は5090なので4bitでいいはずですが余裕を持たせるために一応3bitにしてみてます。

名前やステップ数も自由に変更してください。

私は3000stepにしてますが1500stepの方が人気な気もします。

ここでは見えないですがさらに下にサンプルプロンプトの設定がありますがお好みです。

精度があがりますが面倒くさいので私はだいたいそのままにしてますね

あとはCreate Jobして開始するだけです・・・

開始した後のインストールが長いです。

新しいやつが出るたびに再インストールしているせいでSSDがどんどん埋まっていくので対策を考え中です。

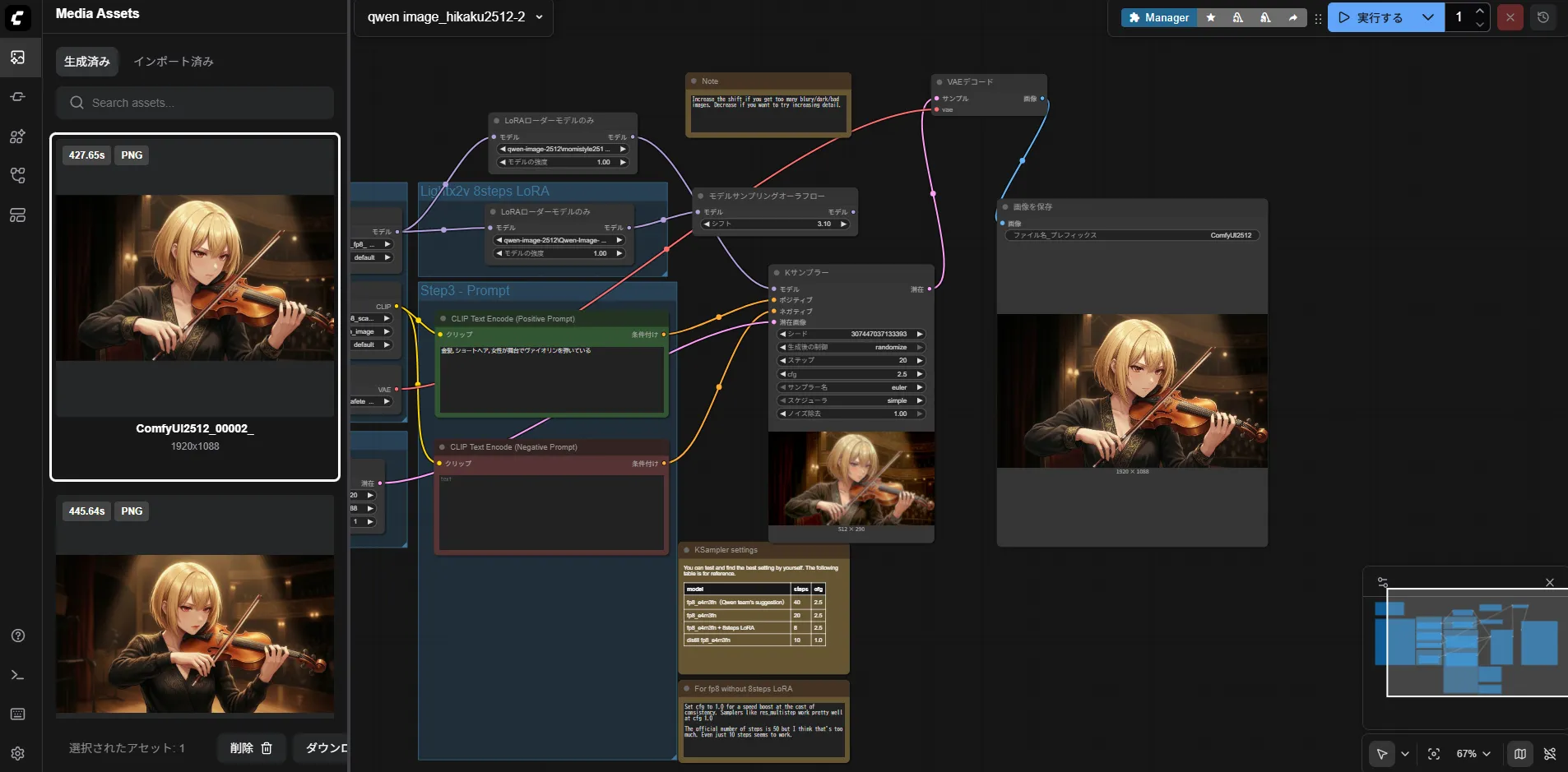

前のLoraを使ってみた

プロンプトは以下です(適当)

見てください前のLoraは完全に死にました。

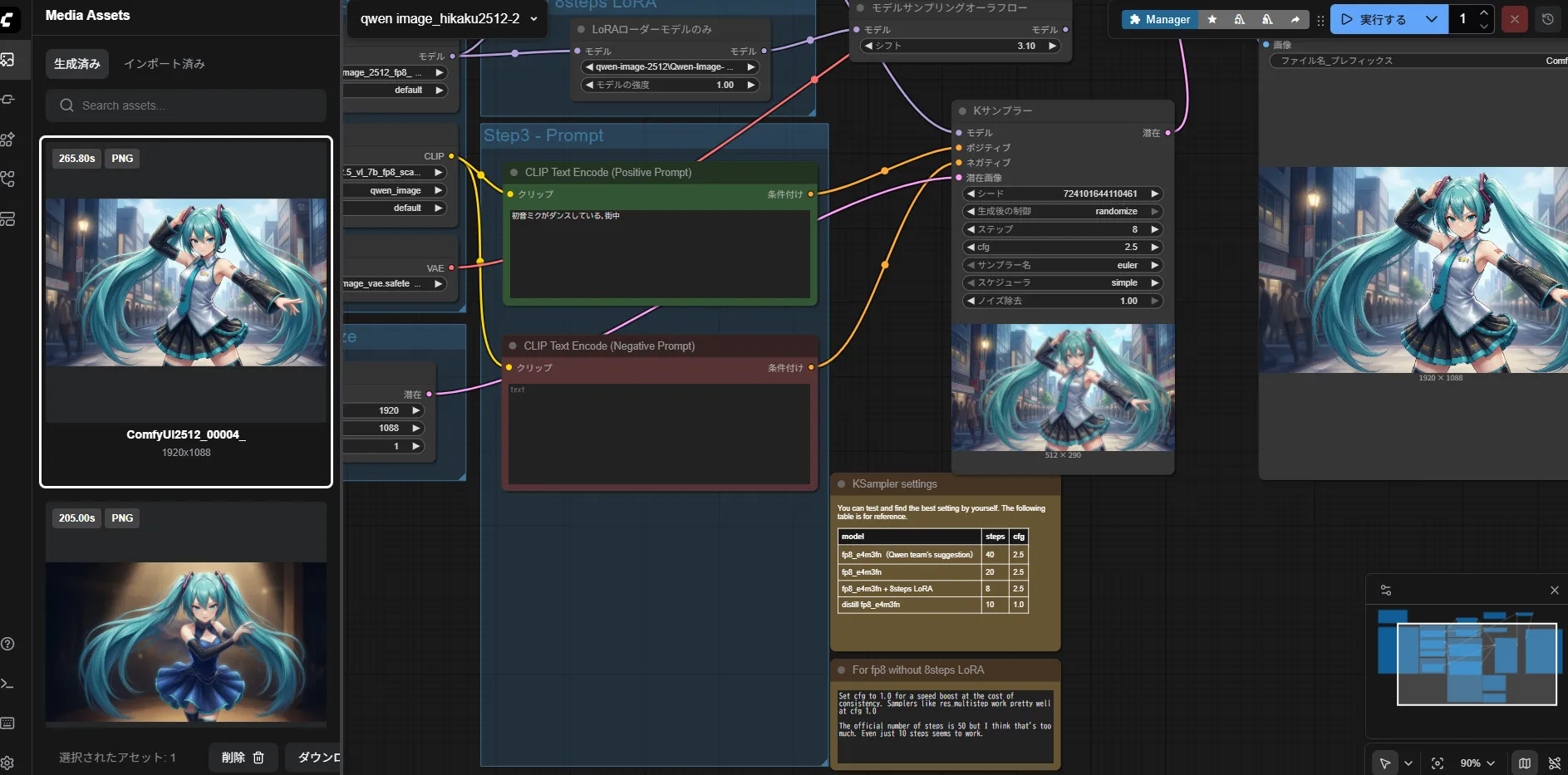

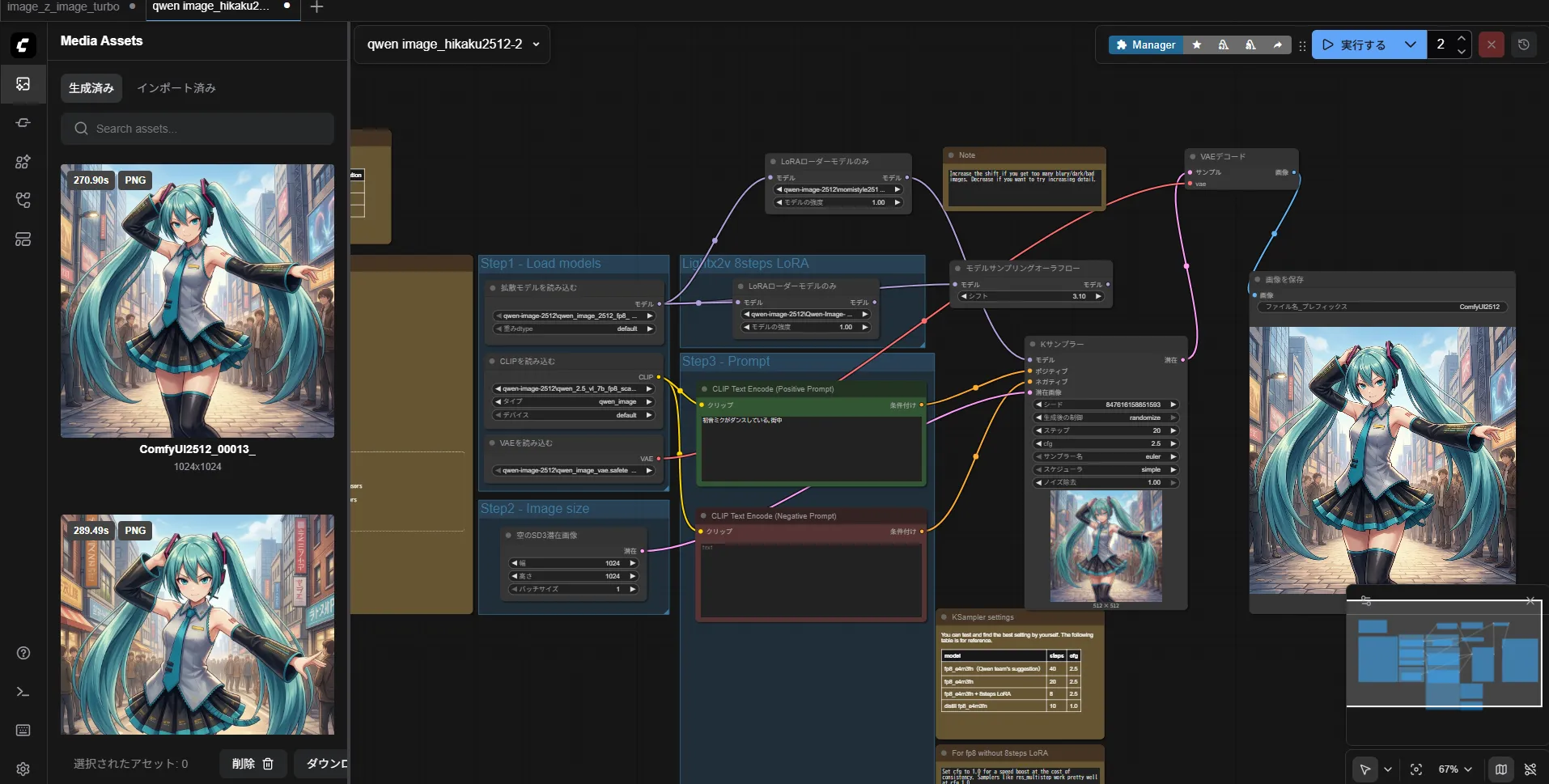

新しいLoraをテストする

プロンプト1

プロンプトは前のLoraと同じです。

いい感じですね。

やっぱりQwen-Imageってプロンプトが同じだと似た構図になりますよね?

Stable Diffusionはランダム要素があって好きだったんですけどね・・

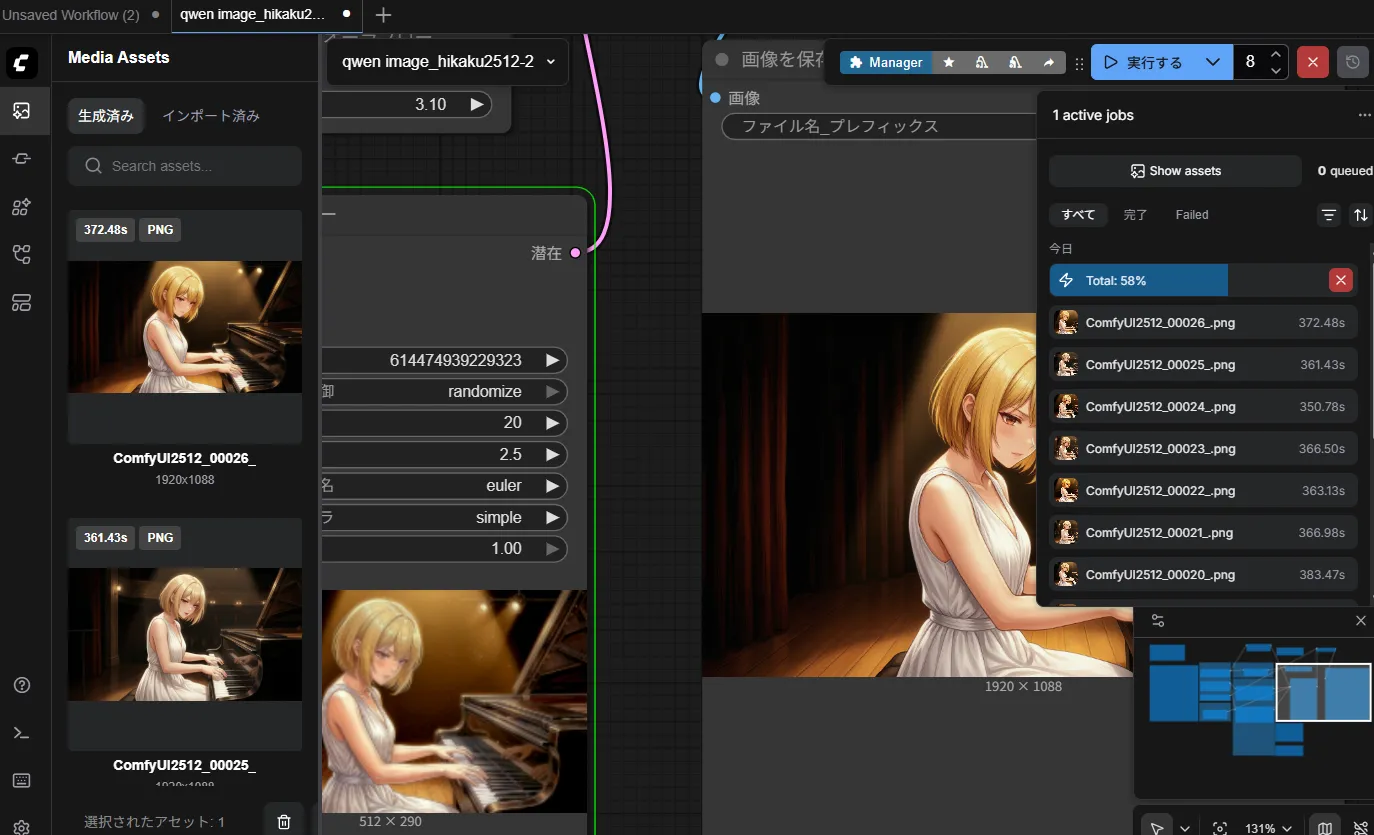

プロンプト2

まぁ、パンダって感じです。

そもそも学習データに動物を含ませてないのでちゃんと出ているのかは不明

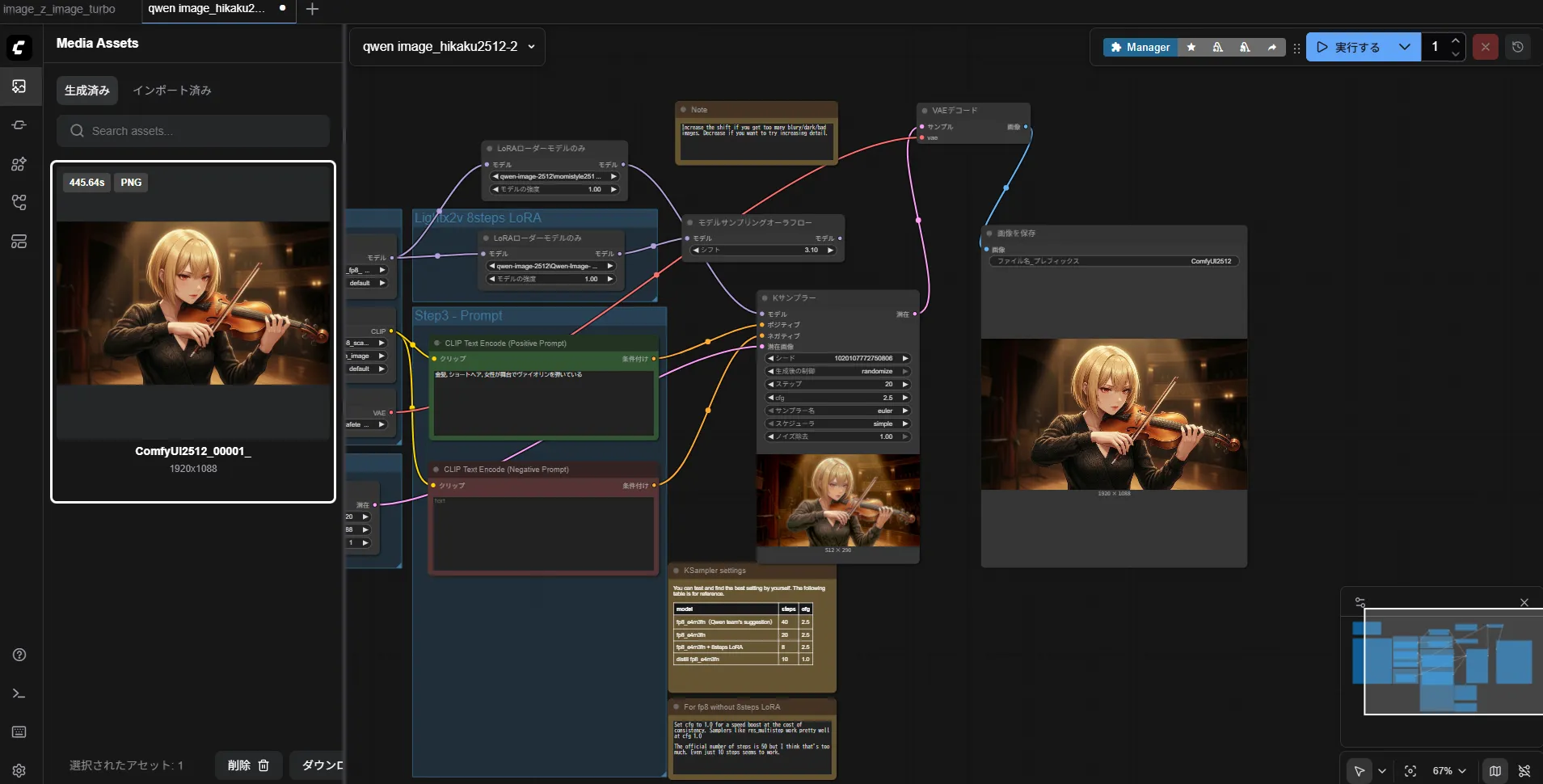

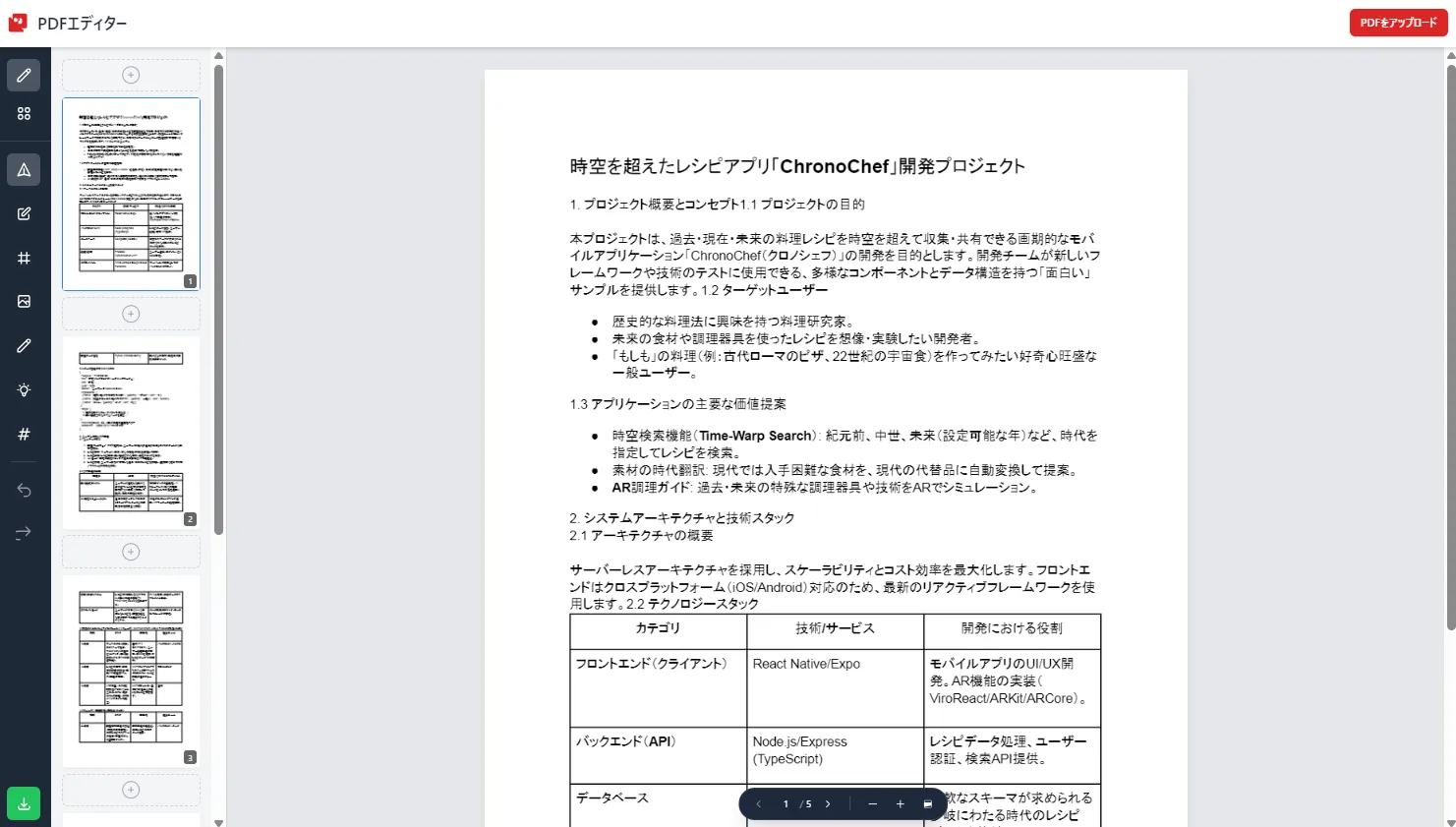

前作のQwen-Imageと簡単に比較してみる

Z-Imageの時に使ったプロンプトと画像をできるだけ流用してます。

生成時間は前作と変わってなかったのでカットします。

プロンプト1

見渡す限りのひまわり畑の中に佇む美少女。風になびく長い髪、背景には夏の巨大な入道雲と透き通るような青空。繊細な光の表現と鮮やかな色彩。キラキラとした瞳、ドラマチックな構図、幻想的な夏の思い出。

Qwen-Image-2512

Qwen-Image

プロンプト2

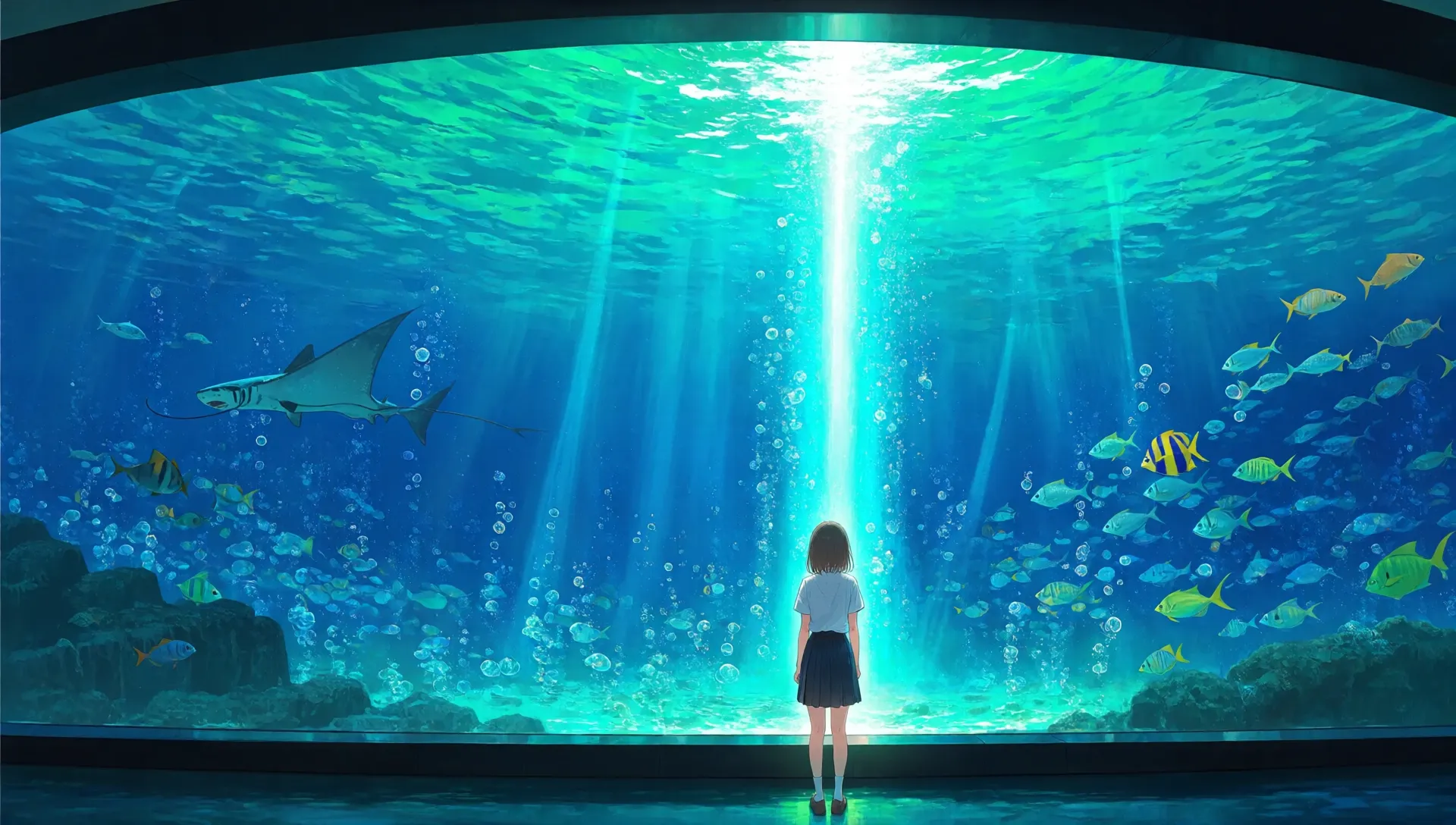

前のやつからコピーして思ったけどこれ前のひまわり畑のやつと合体してたのね(これは直しました)

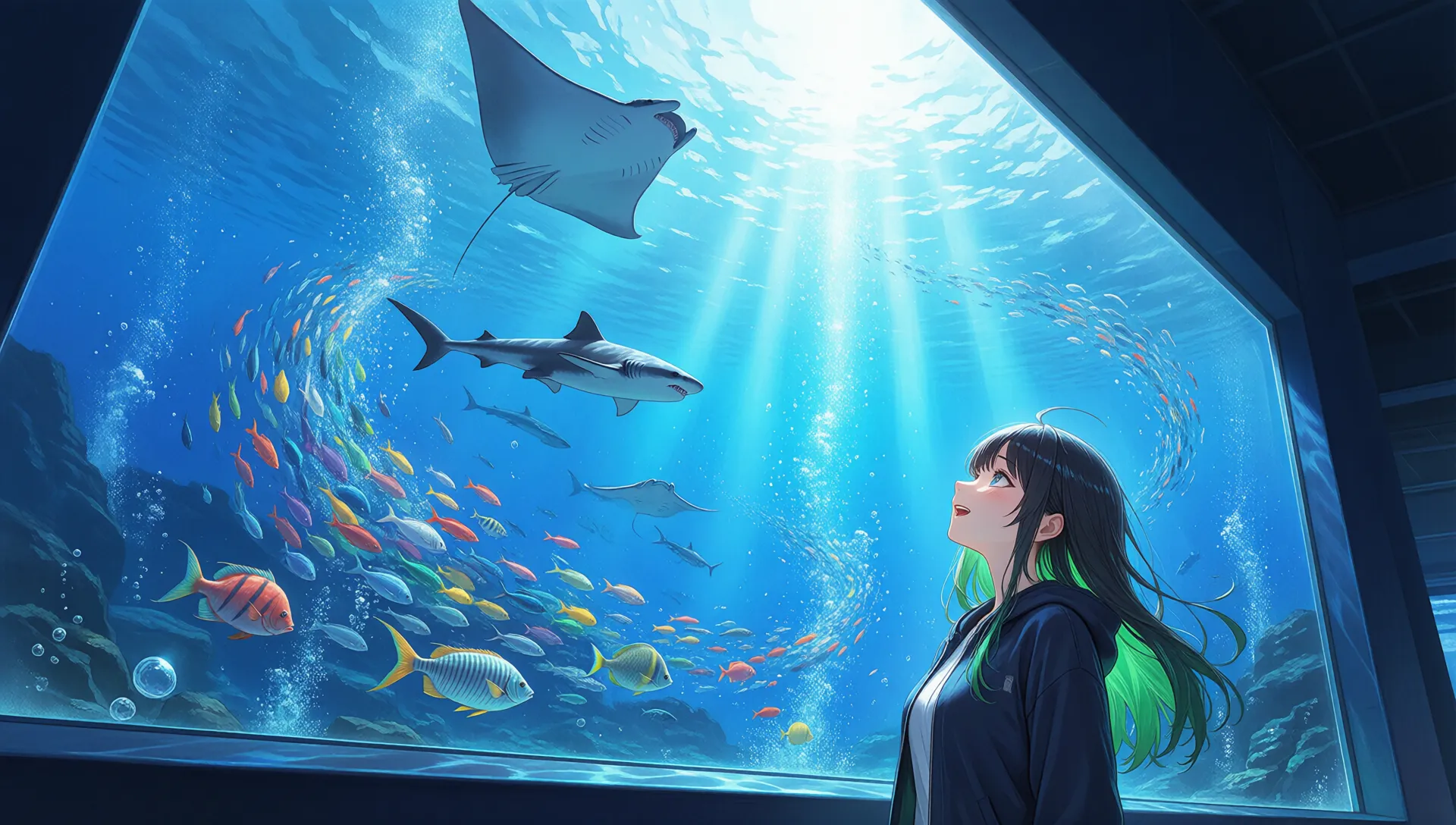

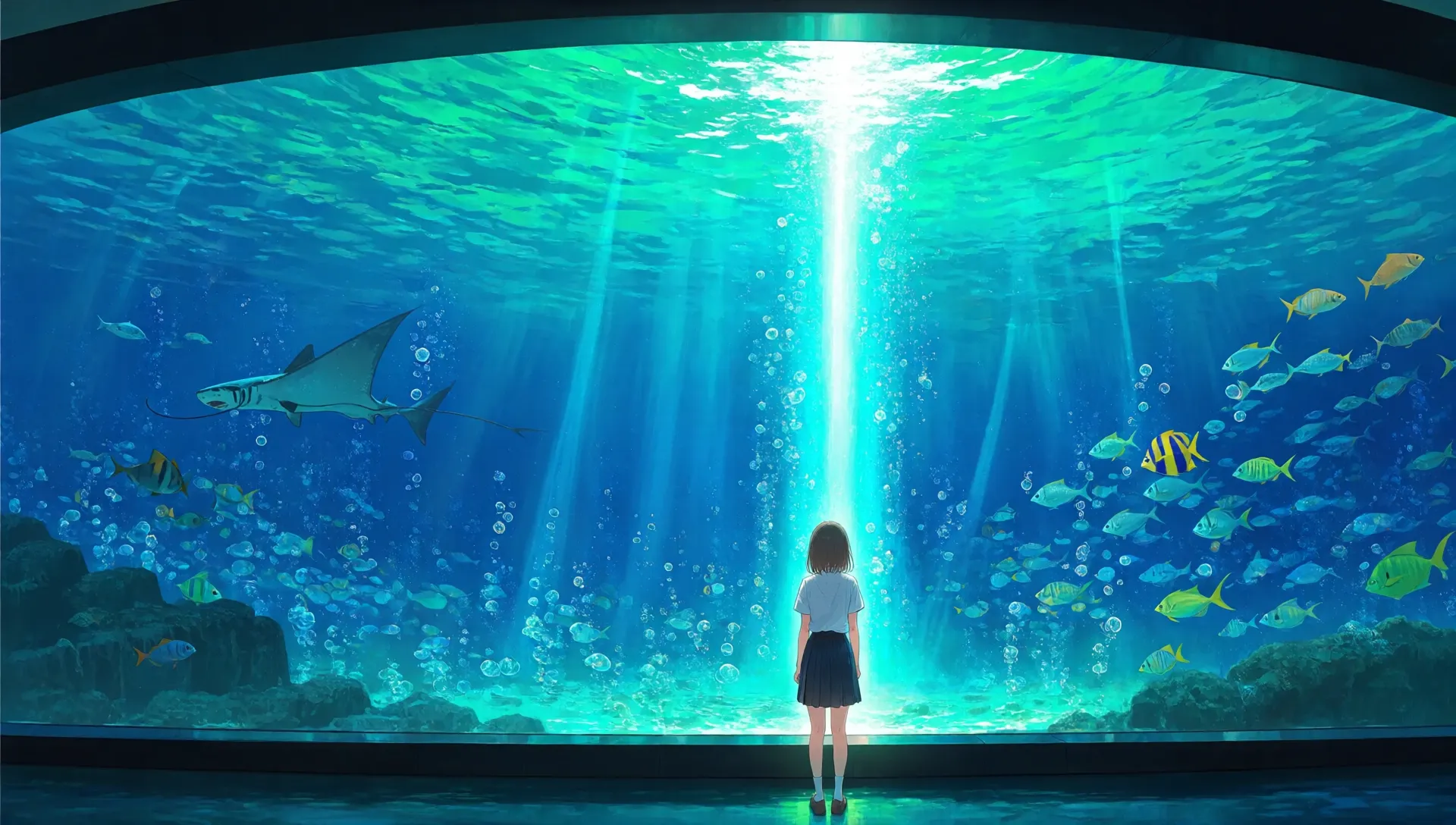

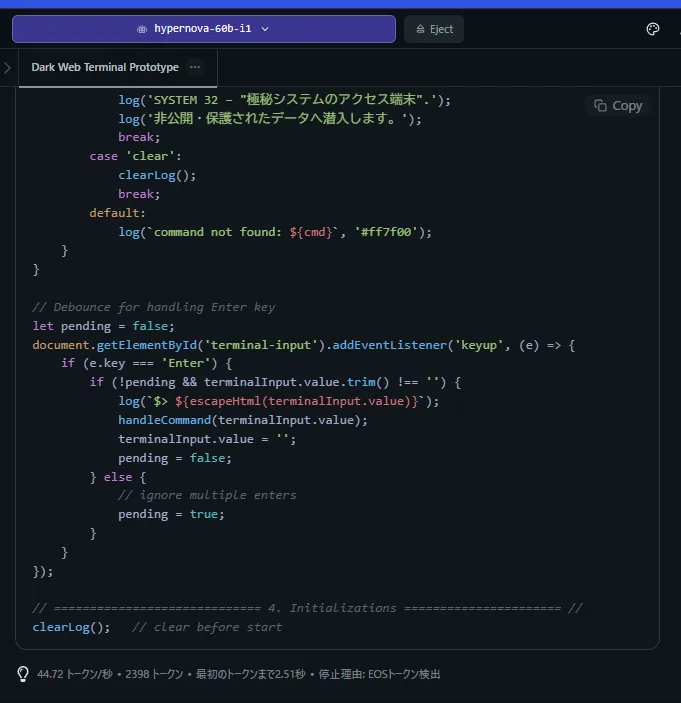

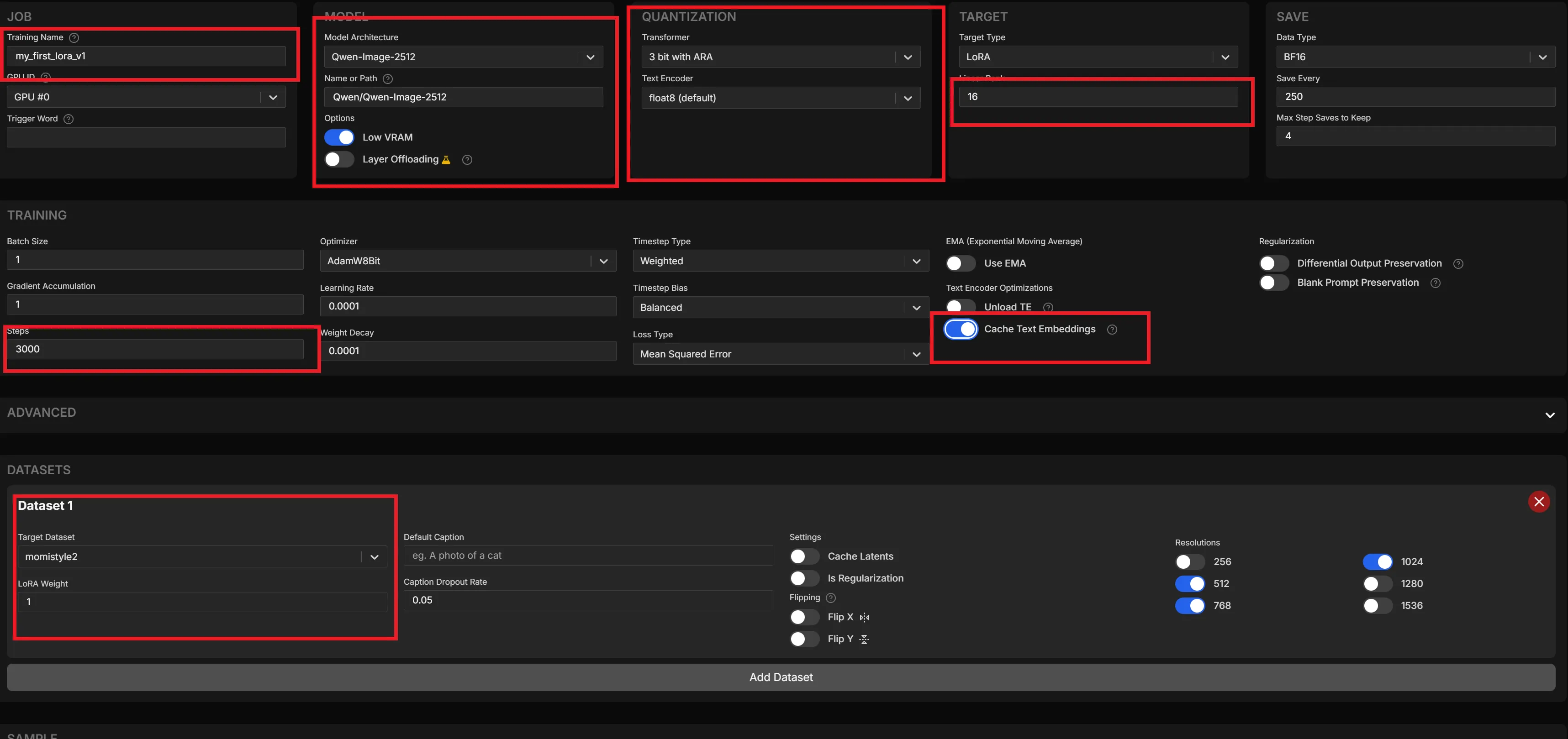

幻想的な水族館。巨大なアクリルパネルの大水槽の前に佇む美少女。深い青とエメラルドグリーンの光が彼女を照らし、水槽の中ではジンベエザメやマンタ、色鮮やかな魚の群れが渦を巻いて泳いでいる。水面から差し込む光の柱(チンダル現象)と、キラキラと輝く無数の泡。少女は感動して水槽を見上げている。繊細で透明感のある背景美術、ドラマチックな構図、鮮烈な色彩。圧倒的な没入感。

Qwen-Image-2512

Qwen-Image

プロンプト3

神聖で幻想的な夜の神社。無限に続く赤い鳥居のトンネル。宙に浮く無数の狐火(きつねび)や灯籠の温かいオレンジ色の光。豪華な着物を着た銀髪の美少女が、振り返っている。周囲には蛍が舞い、森の木々が静かに見守っている。神秘的で静寂な雰囲気、魔法のような光の演出、高精細な描写。

Qwen-Image-2512

Qwen-Image

プロンプト4

ここで少し差が出てますが環境によってLoraが崩れることがあったのですがいい感じになってますね

Qwen-Image-2512

Qwen-Image

プロンプト5

なんとなく3枚生成したので3枚貼っておきます。

プロンプトは例です。

少しいじったりしてます。

1girl,solo,animal ears,brond hair,short hair,sleeveless,elbow gloves,socks,extra ears,sleeveless_shirt,skirt,belt,tail,yellow_eyes,serval,bowtie,arms up,shoe,savannah,scary smile

Qwen-Image-2512

Qwen-Image

プロンプト6

プロンプトをメモり忘れましたが2512が私の作成したLora的には忠実です。

あと指の数を見たらわかるのですが明らかに本数が増える現象が解消されてます。

Qwen-Image-2512

Qwen-Image

めちゃくちゃ変わったかと言われればLoraを適用すると違いはよくわかりませんがLora適用時に指が増える現象は明らかにへってました。

プロンプト6を見てもらえればわかります(まぁ、前の状態でもネガティブプロンプトとかで直せるんですけども)

あとはヴィタちゃんLoraを作ってから比較して学習データなどを増やしてみるか決めたいと思います。

まぁ、1枚360秒はさすがに遅いのに変わりはないですけども

まぁ、1枚360秒はさすがに遅いのに変わりはないですけども

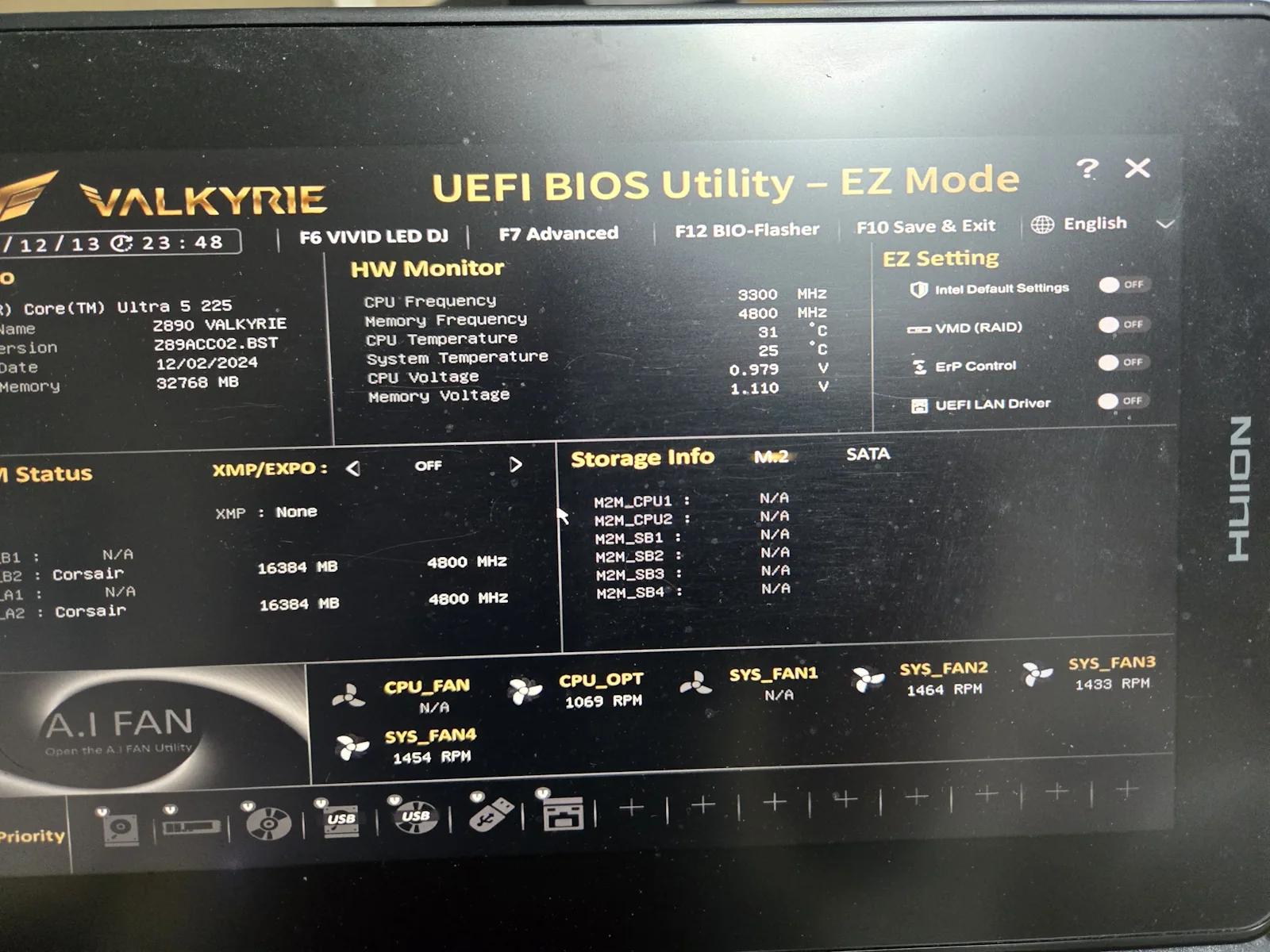

注文番号はつぶしてます

注文番号はつぶしてます

あとケースに背面ファンがなかったので後で追加します。

あとケースに背面ファンがなかったので後で追加します。