Z-Image-TurboのLora作ったからQwen-Imageと比較するぞ

2025年12月1日に追記してます。

画像追加してます。

微妙ですねQwen-Imageのほうがいいです。

Z-Image-Turboは安定しない場合は英語でプロンプトを考える必要があるかもですね。

2025年12月4日に最後にStable Diffusionで使うプロンプトでのテストを追加してます。

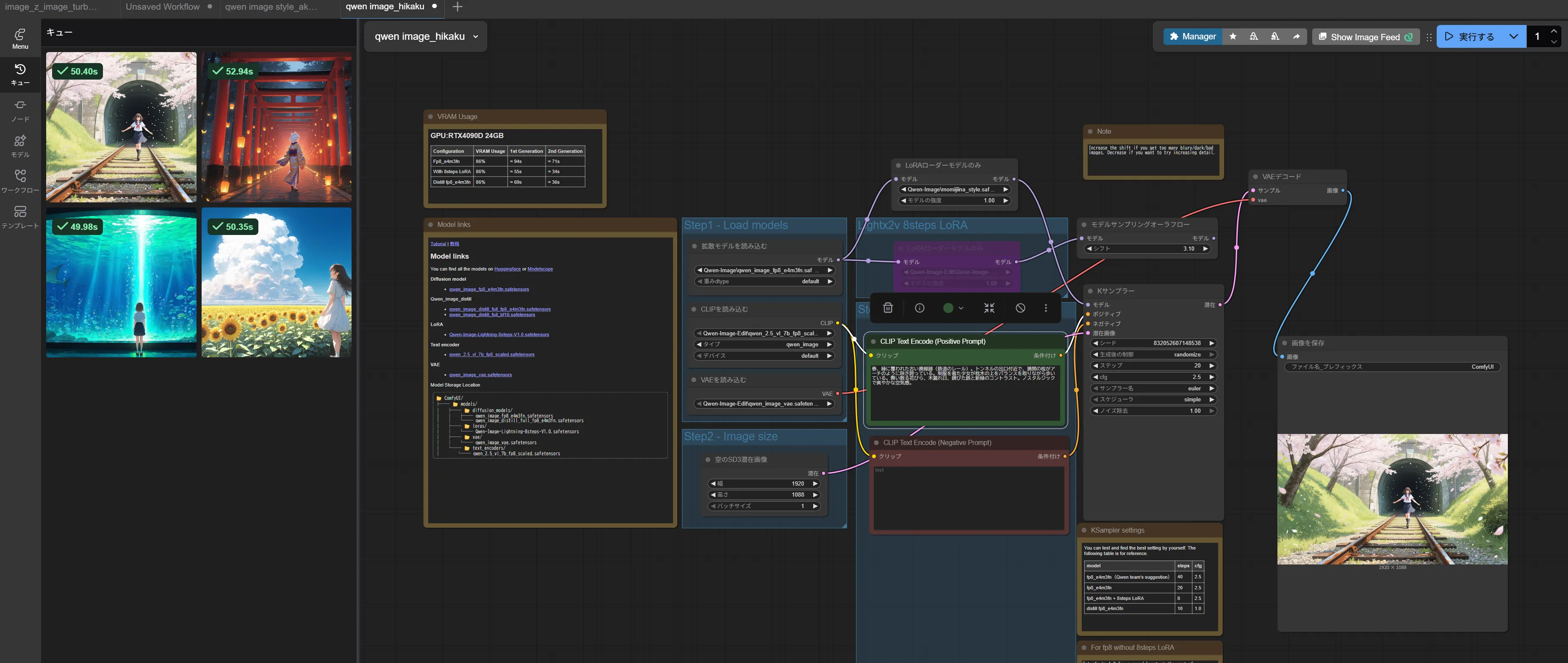

Z-Image-TurboのLoraを作りましたのでQwen-Imageと比較したいと思います。

今回は1920x1088の20ステップでのそれぞれの比較とします。

プロンプトはGemini 3.0 Pro生成です。

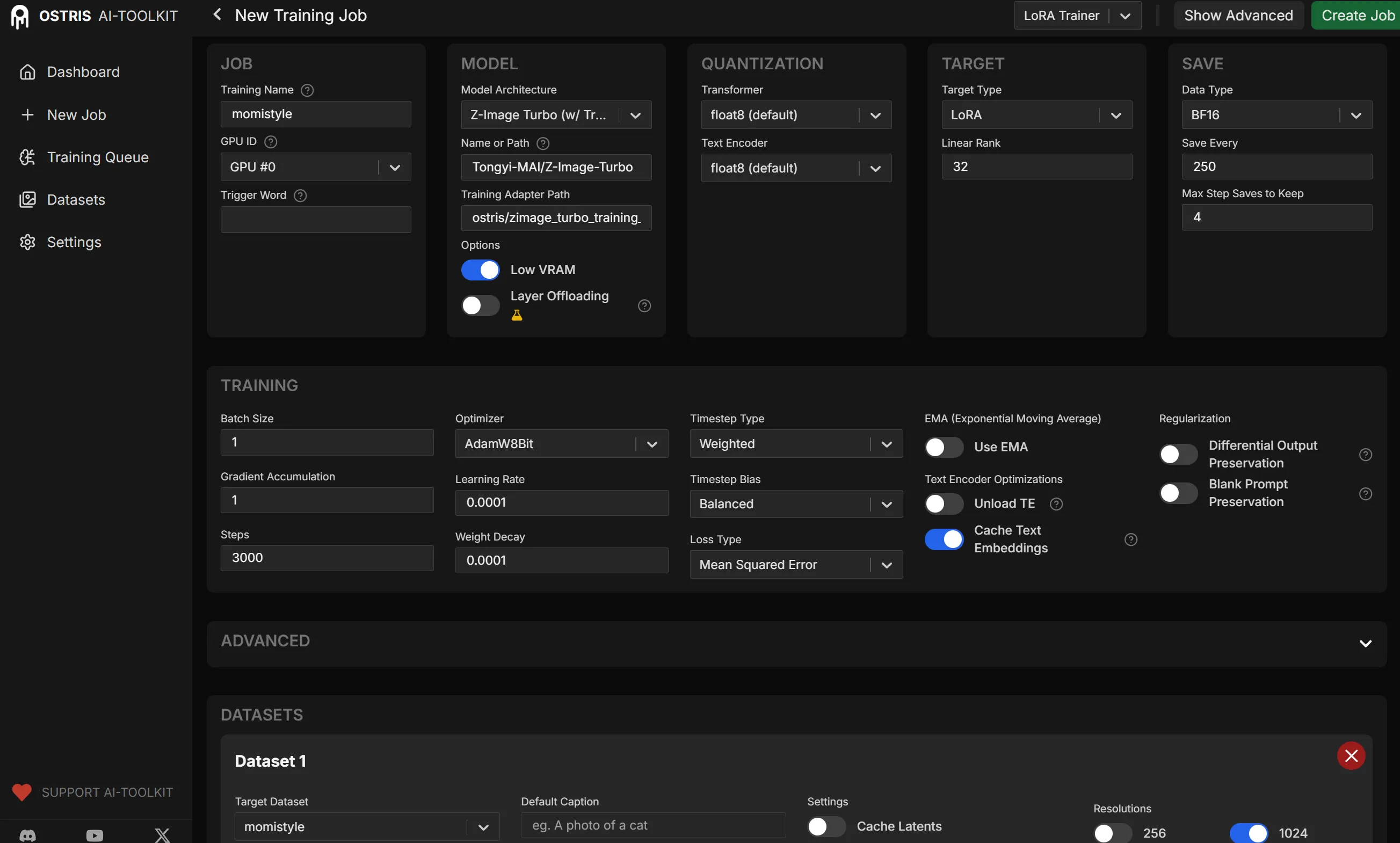

Z-Image-TurboのLoraの作成方法

一応、書いておきます。

今回,Lora作成にはQwen-Imageと同じくai-toolkitを使用しています。

https://github.com/ostris/ai-toolkit

RTX50シリーズだと以下で動きます。

RTX5090で今回もZ-Image専用で再インストールしているので問題ないです。

git clone https://github.com/ostris/ai-toolkit.git

cd ai-toolkit

python -m venv venv

.\venv\Scripts\activate

pip install --pre torch torchvision torchaudio --index-url https://download.pytorch.org/whl/nightly/cu128

pip install -r requirements.txt

起動

cd ui

npm run build_and_start

一回,buildした後は以下のほうが起動が早いです。

cd ui

npm run start

トリガーワードとかは特に今回はなしです。

一応、全体的な設定はこんな感じです(クリック拡大できるようにしときます)

Lora作成時間は1時間ちょうどくらいでしたね。

比較するぞ

プロンプト1

プロンプト1は以下です。

見渡す限りのひまわり畑の中に佇む美少女。風になびく長い髪、背景には夏の巨大な入道雲と透き通るような青空。繊細な光の表現と鮮やかな色彩。キラキラとした瞳、ドラマチックな構図、幻想的な夏の思い出。

Qwen-Image

Z-Image

プロンプト2

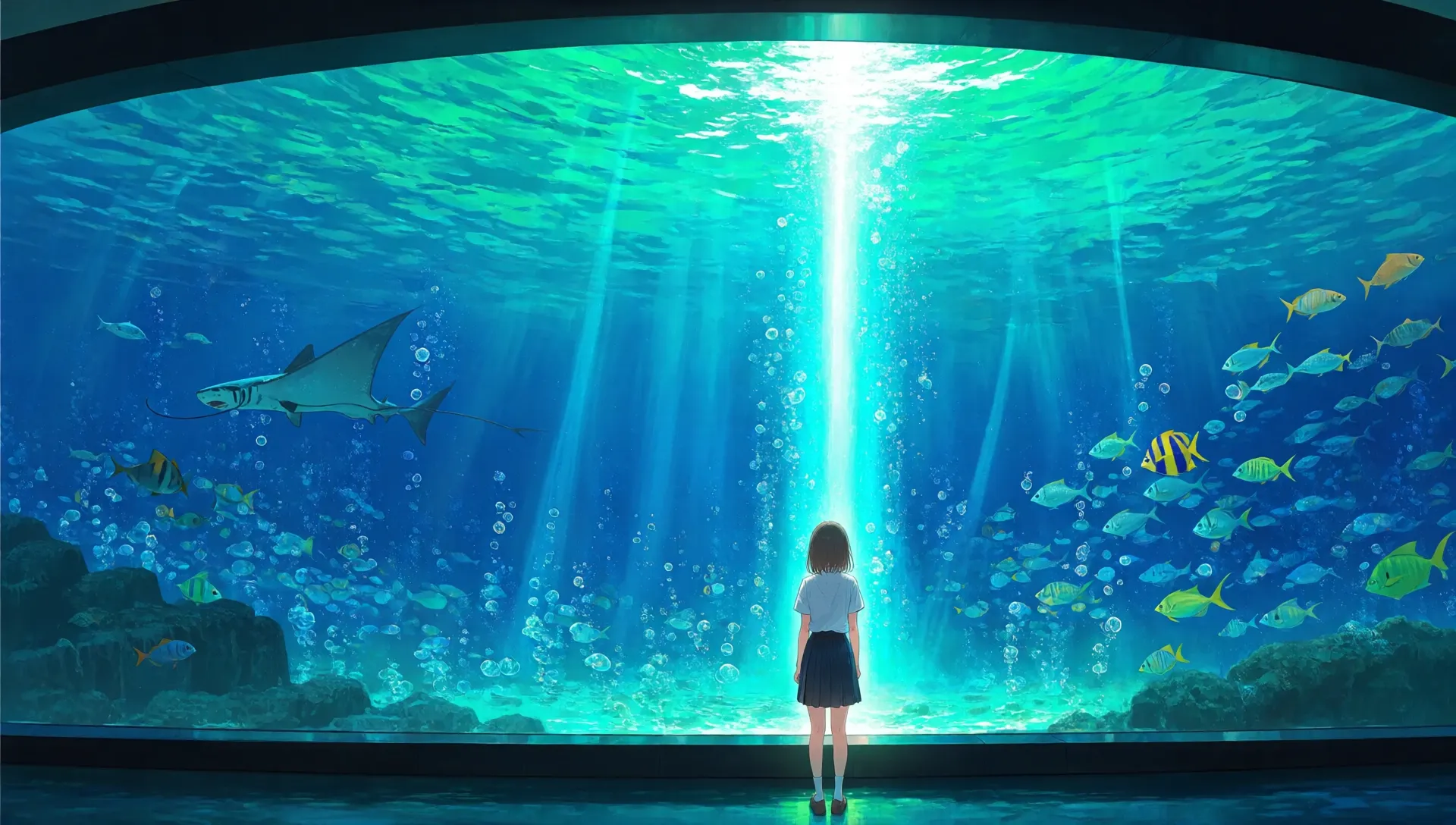

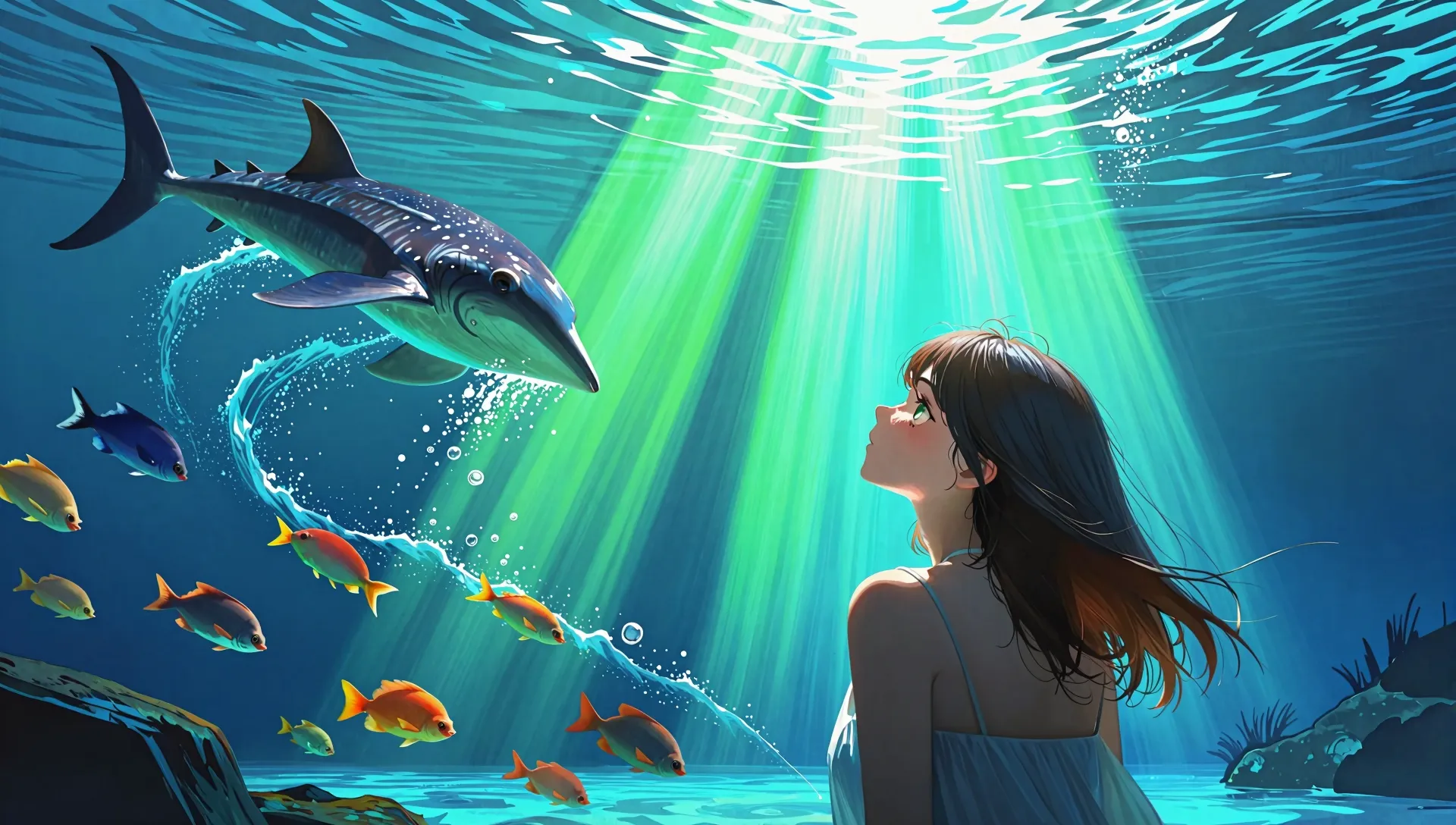

プロンプト2は以下です。

幻想的な水族館。巨大なアクリルパネルの大水槽の前に佇む美少女。深い青とエメラルドグリーンの光が彼女を照らし、水槽の中ではジンベエザメやマンタ、色鮮やかな魚の群れが渦を巻いて泳いでいる。水面から差し込む光の柱(チンダル現象)と、キラキラと輝く無数の泡。少女は感動して水槽を見上げている。繊細で透明感のある背景美術、ドラマチックな構図、鮮烈な色彩。圧倒的な没入感。見渡す限りのひまわり畑の中に佇む美少女。風になびく長い髪、背景には夏の巨大な入道雲と透き通るような青空。繊細な光の表現と鮮やかな色彩。キラキラとした瞳、ドラマチックな構図、幻想的な夏の思い出。

Qwen-Image

Z-Image

プロンプト3

プロンプト3は以下です。

神聖で幻想的な夜の神社。無限に続く赤い鳥居のトンネル。宙に浮く無数の狐火(きつねび)や灯籠の温かいオレンジ色の光。豪華な着物を着た銀髪の美少女が、振り返っている。周囲には蛍が舞い、森の木々が静かに見守っている。神秘的で静寂な雰囲気、魔法のような光の演出、高精細な描写。

Qwen-Image

Z-Image

プロンプト4

プロンプト4は以下です。

春、緑に覆われた古い廃線跡(鉄道のレール)。トンネルの出口付近で、満開の桜がアーチのように咲き誇っている。制服を着た少女が枕木の上をバランスを取りながら歩いている。舞い散る花びら、木漏れ日、錆びた鉄と新緑のコントラスト。ノスタルジックで爽やかな空気感。

Qwen-Image

Z-Image

追加比較と一部不安定?

パラメーターが少ない分一部動作が不安定でした。

LoraはQwen-Imageも同じデータ、同じステップでやっているのでだいたいは似たのができるはずだった。

まぁLora適用しなくても不安定だったのでもしかしたら日本語プロンプトがいけない可能性もあるので英語でやってみましたが微妙でしたね・・・

よくよく考えればプロンプト4も絵柄が違いますもんね。

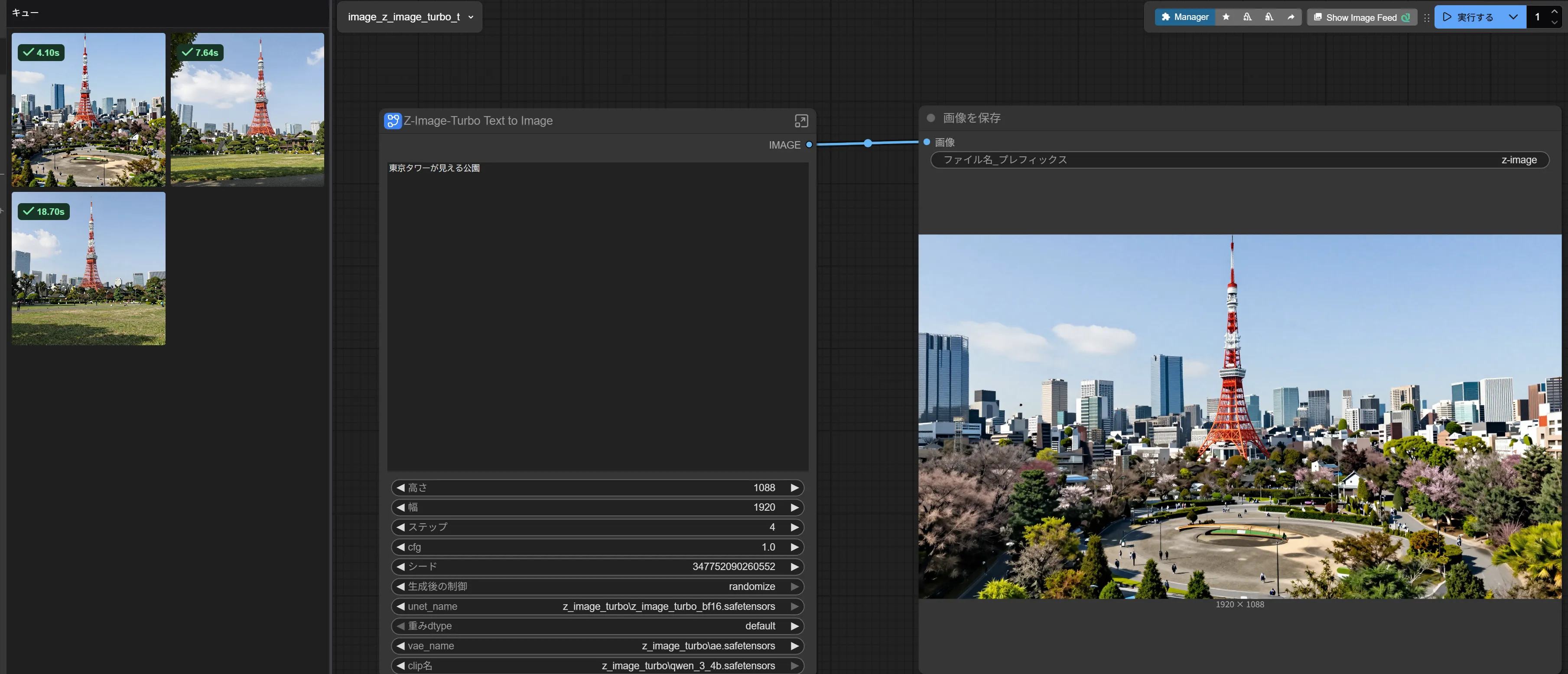

東京タワー

Qwen-Image

Z-Image

Loraの強度を強くしてこれです

Loraの強度を強くしてこれです

水着を着た初音ミクがプールで泳いでいる。

Qwen-Image

Z-Image

一部、動作をさせるとLoraの安定性もわるくなります。

野球させても意味がわからなかったです。

Lora適用時の水の描写が苦手なのかな

Lora適用時の水の描写が苦手なのかな

初音ミクがベッドで寝ている

Z-Imageだけ

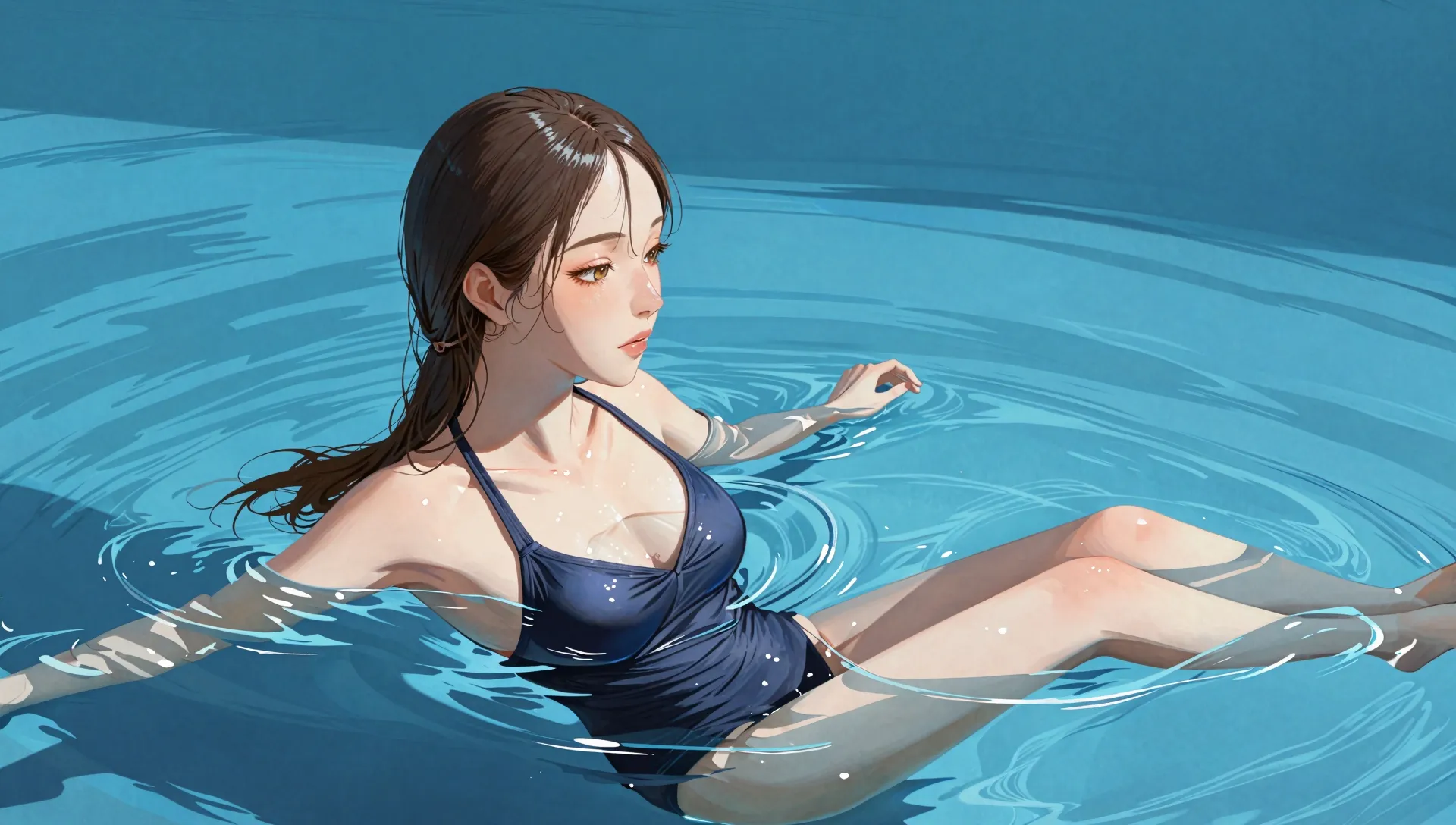

水着の女性がプールにいる。

Qwen-Image

Z-Image

女性が一人,こちらに向かってピースしている

Qwen-Image

Z-Image

Loraもうあきらめきってますがピースサインくらいは・・・

これ生成されたものの中でましなものなんですよ?

一応英語だとこんな感じのが生成されます

A woman is making a peace sign toward us.

そのグーなんだよ。

そのグーなんだよ。

英語でやらないといけないならStable Diffusionでいいので現状は使うことはないです。

Stable Diffusion風プロンプト

ベースを以下にして適当にいじって遊んでました。

1girl,solo,animal ears,brond hair,short hair,sleeveless,elbow gloves,socks,extra ears,sleeveless_shirt,skirt,belt,tail,yellow_eyes,serval,bowtie,arms up,shoe,savannah,scary smile

Qwen-Image

Z-Image

Loraが不安定なのは学習に問題がある可能性もあるのでai-toolkitの更新を待ってみますかね一応・・・

V2データでの学習ですがあんまり変わってなかったです。

プロンプトを増やしてポーズさせるとなぜか場所がうまくでなかったりしますねやっぱ

プロンプトを増やしてポーズさせるとなぜか場所がうまくでなかったりしますねやっぱ

結論

Lora使えばあんまりかわらなそう?

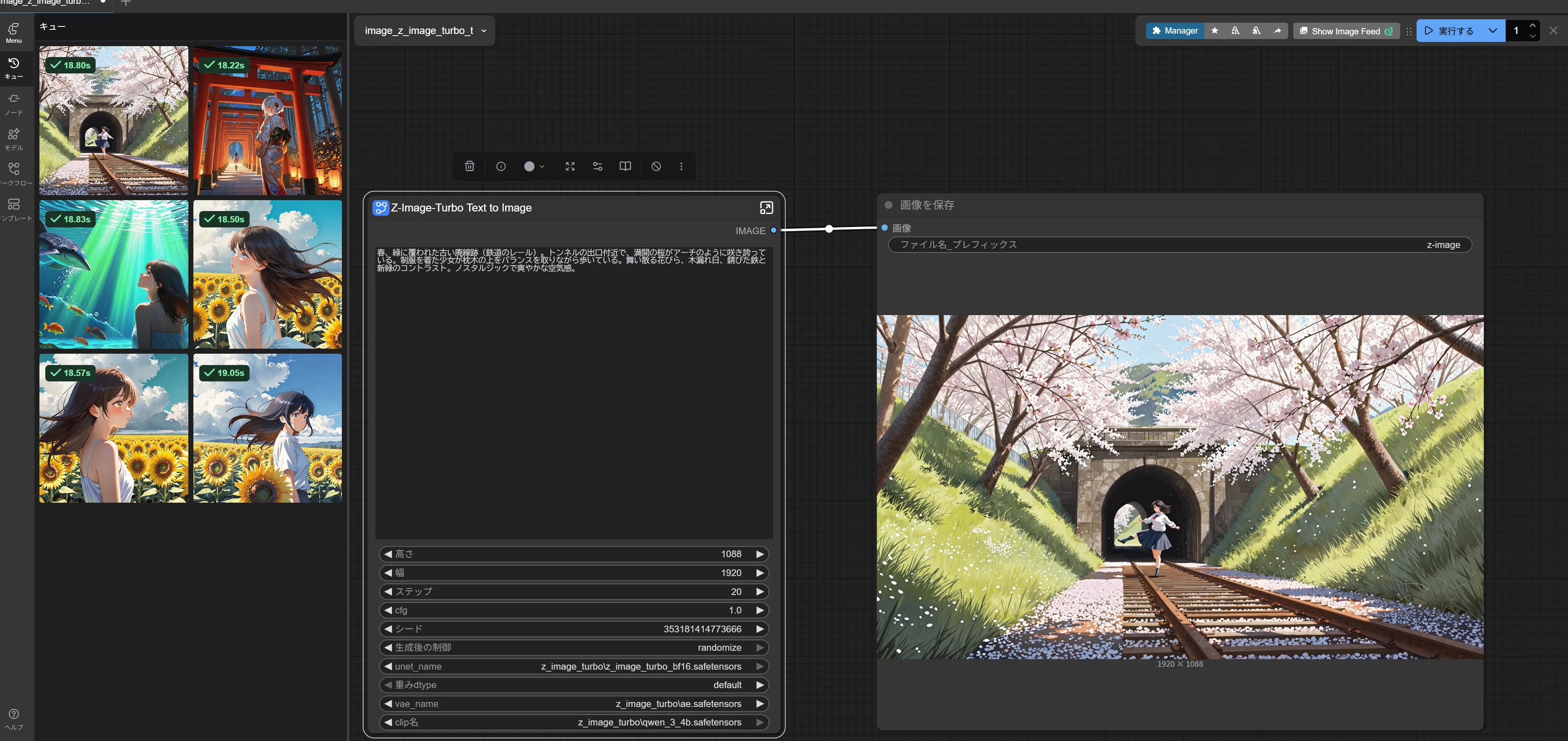

一応、最後に生成に使った画面をそれぞれ張っておきますが速度が圧倒的にZ-Imageは速いです50秒と18秒で同じそうならZ-Image一択ですかね。

4stepにすれば速度はさらに早いです。

この流れだとZ-Image-Turbo-Editもくるのかな?

追記コメント:微妙!使えるならQwen-Imageのほうがいいです。

Civitaiに転がってるモデルでも同じだったのでまぁもういいです。

細かいことさせるとどこで崩壊するかわかないのでQwen-Imageを使うのがいいですね。

英語でやる必要があるならStable Diffusionを使います。

黒板が一体どうなっているのか謎ですがあまり変わらないです。

黒板が一体どうなっているのか謎ですがあまり変わらないです。

線は最初から入ってました

線は最初から入ってました

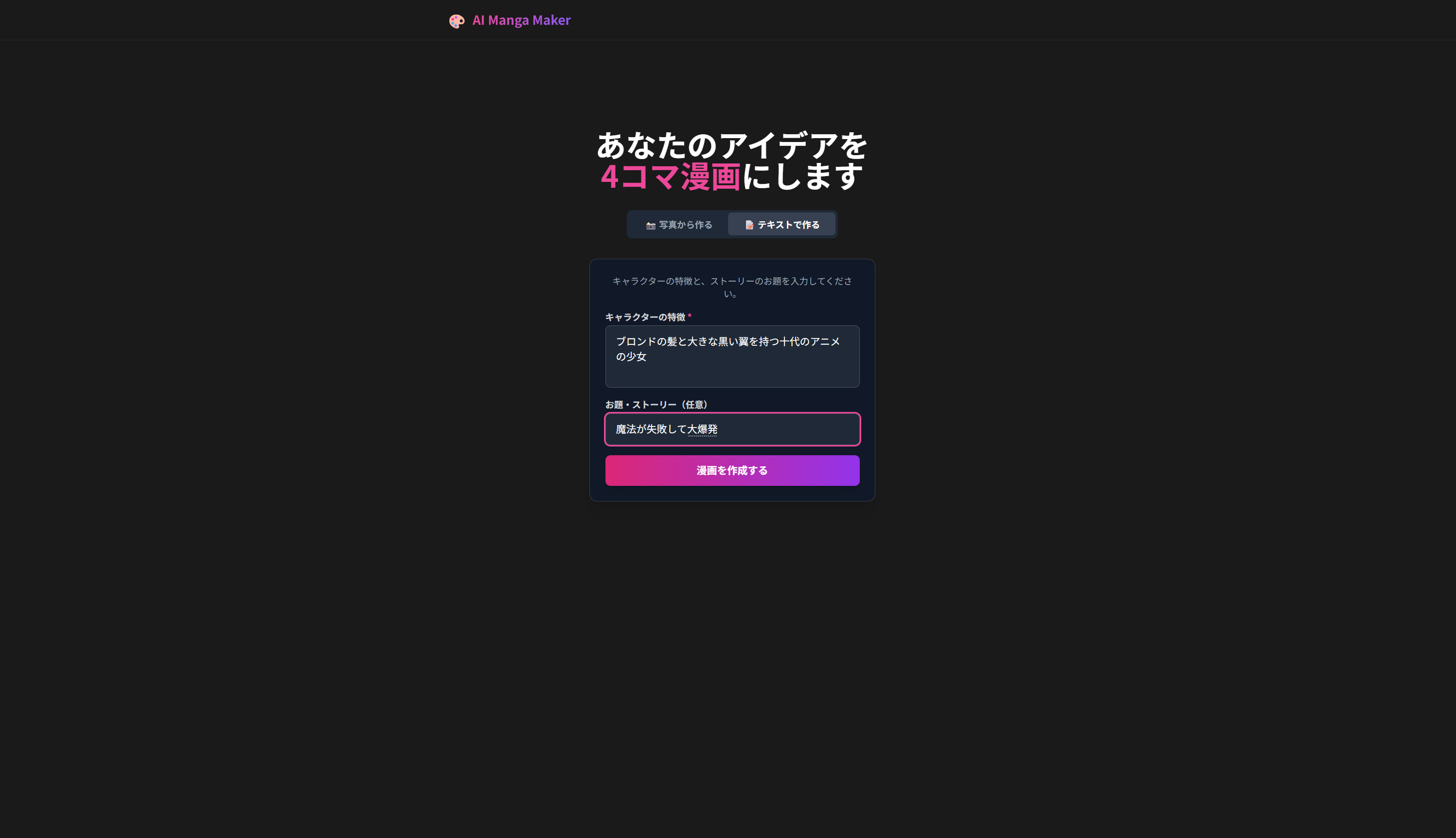

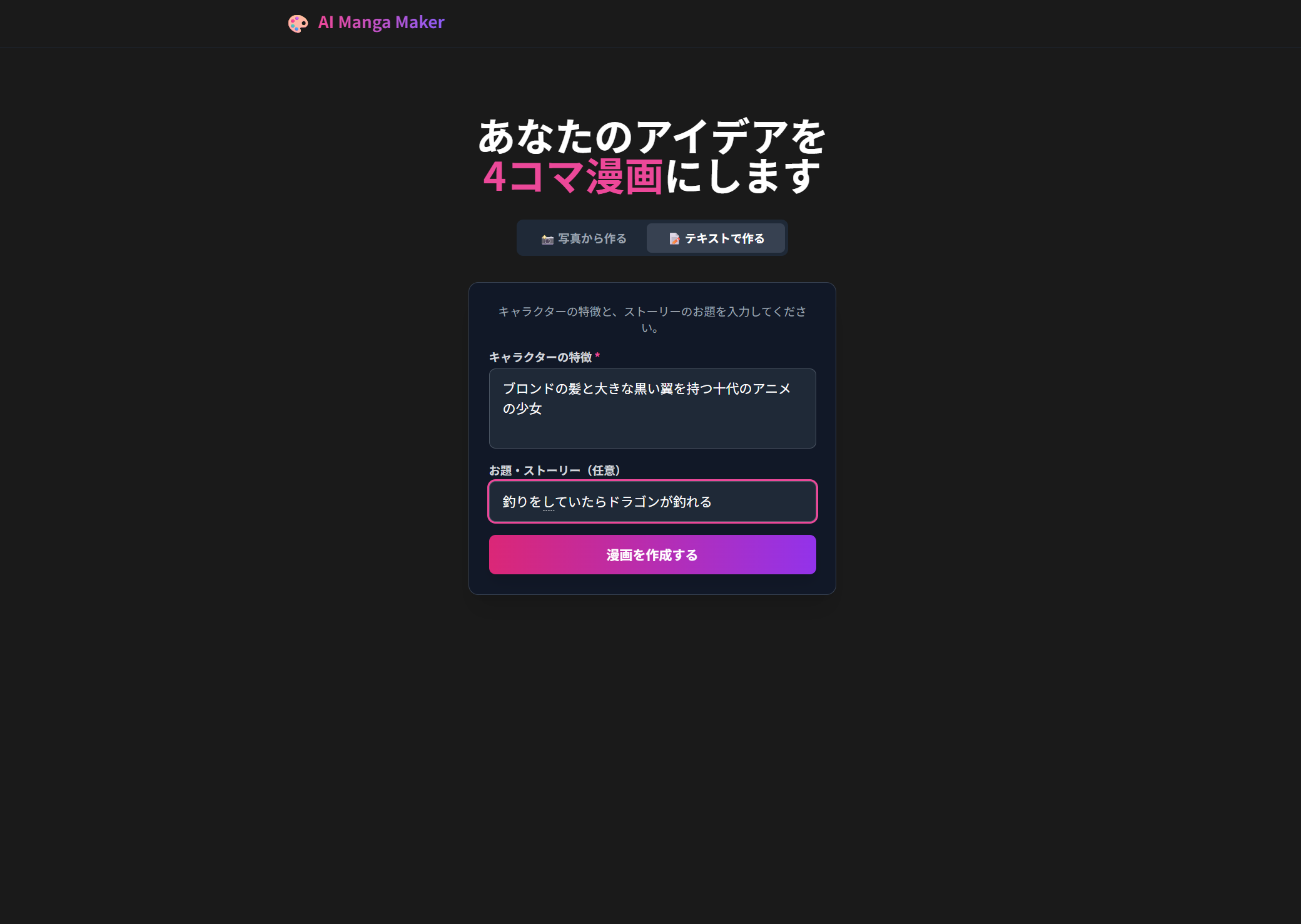

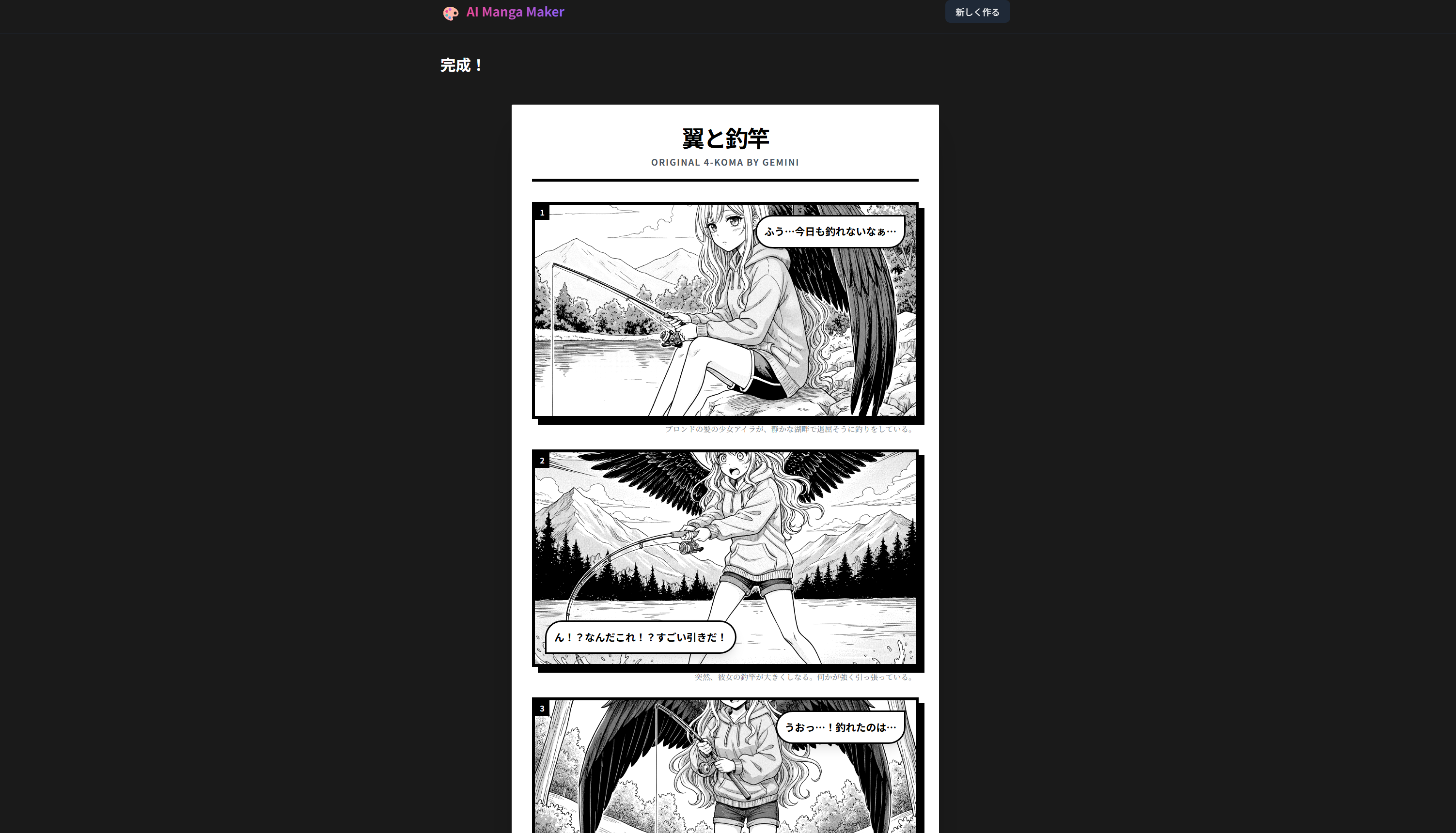

できた漫画

できた漫画

できた漫画2

できた漫画2

アスペクト比修正後

アスペクト比修正後